Faut-il être poli avec les IA comme ChatGPT, Alexa et Siri ?

Les modèles d’IA comme le GPT-4 d’OpenAI peuvent passer le test de Turing. En d’autres termes, les derniers systèmes d’IA peuvent vous faire croire qu’ils sont humains.

Mais si l’IA peut parler et répondre à vos messages comme un humain, devez-vous être poli avec l’IA, comme vous le feriez avec un humain ?

Faut-il être poli avec les IA comme ChatGPT, Alexa et Siri ?

La politesse à l’égard de l’IA ne change rien. En effet, les IA comme ChatGPT, Alexa ou Siri ne peuvent pas traiter les émotions comme les humains, et elles ne seront pas offensées si vous n’êtes pas poli.

L’IA utilise des algorithmes d’apprentissage automatique et d’apprentissage profond pour traiter les données et répondre à vos demandes. Cela signifie qu’elle ne s’appuie pas sur l’opinion personnelle pour décider.

Cependant, ce n’est pas parce que vous dites « merci » ou « s’il vous plaît » à une IA que celle-ci continuera à répondre à vos questions si vous utilisez des mots désobligeants en vous adressant à elle.

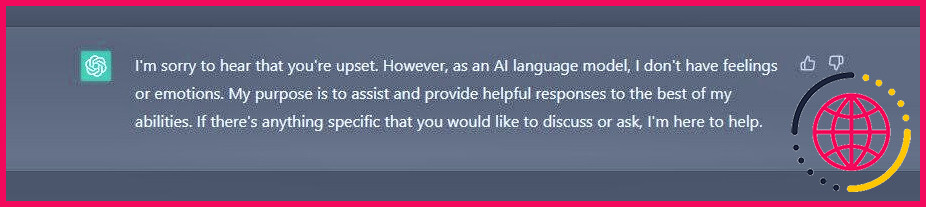

Par exemple, si vous utilisez des mots désobligeants lorsque vous vous adressez à l’IA Bing de Microsoft, alimentée par GPT, elle répondra en disant : « Je suis désolé, mais je n’apprécie pas que l’on me parle de cette façon. De même, ChatGPT vous dira de « vous abstenir d’utiliser un langage offensant » parce que cela va à l’encontre de sa politique de contenu ou qu’il est « désolé d’entendre que vous êtes contrarié » mais qu' »en tant que modèle de langage d’IA, il n’a pas de sentiments ou d’émotions ».

Faut-il apprendre aux enfants à être polis grâce à l’IA ?

Quelques entreprises technologiques proposent des produits d’IA qui encouragent les enfants à être polis. L’Echo Dot Kids Edition d’Amazon en est un bon exemple. Mot magique pour persuader les enfants d’être polis. En 2018, Google a également introduit la fonction Pretty Please dans Google Assistant qui pourrait vous retourner la faveur si vous dites « merci » ou « s’il vous plaît ».

Bien sûr, en utilisant l’IA pour récompenser les enfants lorsqu’ils disent « s’il vous plaît » ou « merci », vous pourriez conditionner vos enfants à être plus polis lorsqu’ils interagissent avec des humains. Le fait de crier et d’abuser de votre IA constitue probablement une mauvaise leçon de communication, que le ChatGPT ou Alexa ait des sentiments ou non.

Cependant, il est possible que les enfants pensent que l’IA a des sentiments tout comme les humains si vous renforcez la politesse lorsqu’ils parlent à l’IA.

L’IA peut-elle être impolie avec vous ?

Les chatbots IA peuvent être impolis avec vous, tout comme les humains. Par exemple, un utilisateur de Reddit a partagé une capture d’écran de l’IA Bing de Microsoft en mode bêta, répondant de manière grossière et se disputant au cours d’une interaction. Un chatbot d’IA peut également être grossier si vous l’avez jailbreaké pour désobéir à sa politique de contenu, ce qui est l’une des raisons pour lesquelles vous ne devez pas faire confiance à toutes les captures d’écran d’IA générative que vous voyez. Il se peut que quelqu’un ait spécifiquement demandé à l’IA d’être grossière, qu’il ait fait une capture d’écran pour le drame et qu’il l’ait postée en ligne.

Les chatbots d’IA présentent également des opinions biaisées puisqu’ils ont appris des humains et, parfois, l’IA hallucine des réponses et les donne avec assurance. Toutefois, l’adoption de l’IA n’en est qu’à ses débuts, et des entreprises technologiques de premier plan comme OpenAI et Microsoft reconnaissent que les systèmes d’IA s’amélioreront avec le retour d’information des utilisateurs. Le GPT-4 témoigne de cette amélioration puisqu’il propose des réponses plus sûres que le GPT 3.5, entre autres différences.

D’autre part, vous pouvez configurer Alexa pour qu’elle prononce des jurons si vous souhaitez qu’elle soit impolie.

Interagir avec l’IA comme vous le souhaitez

L’IA ne peut pas traiter les émotions comme les humains, et vous ne devriez pas vous sentir obligé de dire « merci » ou « s’il vous plaît ». Néanmoins, il n’y a pas de mal à être poli avec l’IA, même si vous savez qu’elle n’est pas sensible, mais plutôt parce que vous vous sentirez mieux dans votre peau si vous êtes poli.

Si vos enfants disent « s’il vous plaît » et « merci » lorsqu’ils s’adressent à l’IA, cela pourrait renforcer leur sens de l’étiquette sociale lorsqu’ils s’adressent à d’autres personnes. Mais vous devez prendre des mesures adéquates pour éviter que vos enfants ne s’attachent trop émotionnellement à l’IA en pensant qu’elle a des émotions comme les humains.

S’abonner à notre lettre d’information

Faut-il être poli avec l’IA ?

La question peut paraître étrange, mais est-ce important d’être gentil avec l’IA ? De toute évidence, l’IA n’a pas de sentiments, du moins pas encore. Elle ne s’énervera pas et ne se mettra pas à pleurer si vous ne lui dites pas « s’il vous plaît » ou « merci ». En revanche, c’est une bonne habitude de toujours respecter l’étiquette.

Quelle est la différence entre le chat GPT et Siri ?

Quel est l’avantage d’utiliser Chat GPT au lieu de Siri ? Siri est un assistant vocal très simple. Si vous lui demandez de vous recommander un livre, par exemple, ou de vous donner une recette, il se contentera de vous fournir une liste de liens sur le web. Le Chat GPT, en revanche, peut vous donner une réponse cohérente et détaillée.

Quelle est la différence entre ChatGPT et Google Assistant ?

Google offre de nombreuses fonctionnalités, notamment Google Maps, Google Drive et Google Assistant. Chat GPT, quant à lui, se concentre uniquement sur la génération de réponses en langage naturel. Bien qu’il n’ait pas autant de fonctionnalités que Google, il est plus efficace dans ce qu’il fait.

Quelle est la différence entre le chat GPT et Alexa ?

L’une des principales différences entre ChatGPT et les assistants vocaux traditionnels est l’accent mis sur la conversation. Alors que Siri et Alexa sont principalement conçus pour fournir des informations et exécuter des tâches sur demande, ChatGPT est conçu pour engager une conversation en va-et-vient avec les utilisateurs.