Que sont les boîtes noires de l’IA et comment fonctionnent-elles ?

Lorsque l’on parle de boîtes noires, on pense probablement aux enregistreurs de données utilisés principalement dans les avions de ligne. Cependant, rien n’est moins vrai en ce qui concerne les boîtes noires de l’IA.

Une boîte noire d’IA n’a rien de physique. Les boîtes noires de l’IA sont des entités virtuelles. Elles existent uniquement dans les algorithmes, les données et les systèmes informatiques.

Les boîtes noires de l’IA sont un concept qui fait référence à la prise de décision autonome dans les systèmes d’IA. Examinons en détail les boîtes noires de l’IA, leur fonctionnement et les préoccupations qui les entourent.

Que sont les boîtes noires de l’IA ?

Une boîte noire d’IA est un système indépendant qui peut prendre des décisions sans expliquer comment ces décisions ont été prises. C’est une définition simple de la boîte noire de l’IA.

Cependant, cette définition résume l’essence même de l’intelligence artificielle. Les systèmes d’IA sont conçus pour apprendre, analyser des données et prendre des décisions sur la base des modèles et des corrélations qu’ils apprennent. Cependant, cette définition résume également les préoccupations qui entourent l’IA.

Nous mettrons ces préoccupations de côté pour le moment en examinant le fonctionnement des boîtes noires de l’IA.

Comment fonctionnent les boîtes noires de l’IA

Trois éléments principaux s’intègrent pour créer les boîtes noires de l’IA. Ils se combinent pour créer le cadre qui constitue une boîte noire :

- Les algorithmes d’apprentissage automatique: Les algorithmes d’apprentissage profond fonctionnent en permettant à l’IA d’apprendre à partir des données, d’identifier des modèles et de prendre des décisions ou de faire des prédictions sur la base de ces modèles.

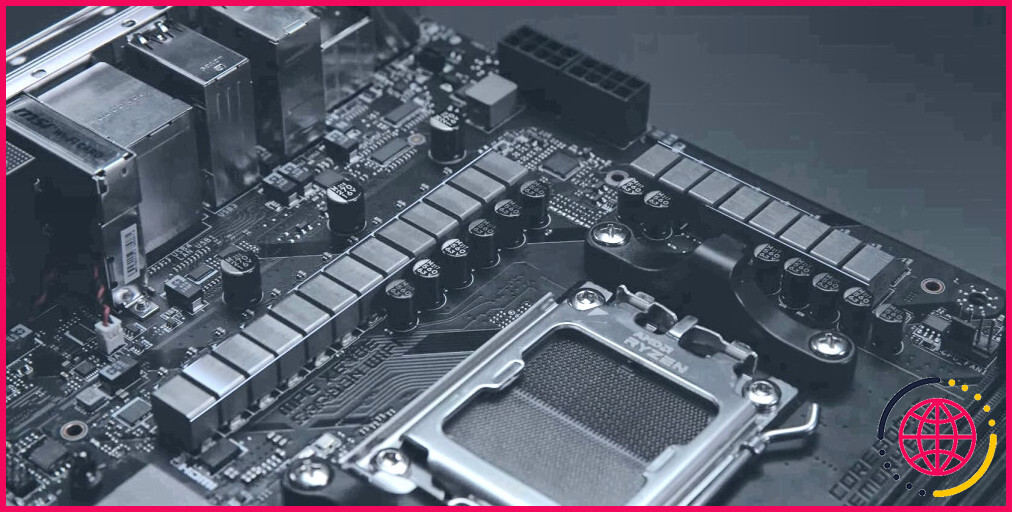

- Puissance de calcul: Les boîtes noires de l’IA ont besoin d’une puissance de calcul importante pour traiter les grandes quantités de données requises.

- Données: D’énormes référentiels de données, atteignant parfois des trillions de mots, sont nécessaires pour permettre la prise de décision.

Le principe est que les boîtes noires de l’IA utilisent ces trois éléments pour reconnaître des modèles et prendre des décisions en fonction de ceux-ci. Les boîtes noires d’IA peuvent également être formées en affinant les algorithmes et en personnalisant les données.

Les systèmes sont exposés à des ensembles de données pertinents et à des exemples de requêtes pendant la formation afin d’optimiser leurs performances. L’accent peut être mis sur des paramètres tels que l’efficacité et la précision.

Une fois la phase de formation terminée, les boîtes noires peuvent être déployées pour prendre des décisions indépendantes sur la base des algorithmes et des modèles appris. Cependant, le manque de transparence sur la manière dont les décisions sont prises est l’une des principales préoccupations concernant les boîtes noires de l’IA.

Défis et risques des boîtes noires d’IA

Les technologies de rupture sont rarement accompagnées d’un bagage. L’IA est la technologie la plus perturbatrice à laquelle nous ayons été confrontés au cours de ce siècle, et elle est certainement accompagnée de nombreux bagages. Pour que l’IA tienne ses promesses, ces défis doivent être relevés. Voici quelques-uns des principaux problèmes et risques :

- Le manque de transparence: On pourrait comparer cette situation à celle d’un étudiant en examen qui rédige une réponse sans montrer son travail. Le manque de transparence quant à la manière dont une décision a été prise est la principale préoccupation liée à cette technologie.

- Responsabilité: Cette technologie est loin d’être parfaite et l’IA commet des erreurs. Mais où se situe la responsabilité en cas d’erreur de la boîte noire de l’IA ? Les conséquences sont graves, en particulier dans des domaines tels que les soins de santé et la finance.

- Équité et partialité: L’adage informatique « Garbage In, Garbage Out » est toujours d’actualité à l’ère de l’intelligence artificielle. Les systèmes d’intelligence artificielle dépendent toujours de l’exactitude des données qui leur sont fournies. Si ces données contiennent des biais, ceux-ci peuvent se manifester dans les décisions qu’ils prennent. Les biais de l’IA constituent l’un des principaux défis auxquels sont confrontés les développeurs.

- Implications juridiques et éthiques: C’est un autre facteur qui peut être attribué au manque de transparence de ces systèmes. Des dilemmes juridiques et éthiques peuvent en découler.

- Perception et confiance du public: Là encore, le manque de transparence est au cœur du problème. Cela peut éroder la confiance du public dans ces systèmes, rendant les utilisateurs réticents à se fier aux processus décisionnels des systèmes d’IA.

Il s’agit de défis connus, et des efforts sont en cours pour développer des systèmes d’IA plus responsables et transparents qui peuvent « montrer leur fonctionnement ».

Que réserve l’avenir aux boîtes noires de l’IA ?

Commençons par dire que l’IA, sous une forme ou une autre, nous accompagnera à long terme. La boîte de Pandore a été ouverte et elle n’est pas prête de se refermer. Cependant, cette technologie en est encore à ses débuts et il n’est pas surprenant qu’elle soulève des défis et des problèmes.

Les développeurs travaillent à l’élaboration de modèles plus transparents qui permettront d’apaiser les nombreuses inquiétudes suscitées par cette technologie. Parmi les mesures prises, citons

- Cadres éthiques et juridiques: Les experts et les décideurs politiques travaillent à l’établissement de cadres juridiques et éthiques qui régiront l’utilisation de l’IA. Les objectifs sont notamment la protection de la vie privée, la garantie de l’équité et la responsabilité dans les applications de l’IA.

- La transparence: Les développeurs travaillent sur des techniques qui permettront de mieux comprendre les étapes de la prise de décision des applications d’IA. En fin de compte, cela vise à renforcer la confiance dans les décisions de l’IA en garantissant aux utilisateurs qu’il existe une trace écrite qui peut être suivie pour retracer la logique qui sous-tend les décisions.

- Outils d’interprétabilité : Ces outils sont développés pour clarifier les décisions opaques prises par les systèmes de boîte noire de l’IA. En fin de compte, l’objectif est de développer des outils qui « montrent les rouages » de la manière dont les décisions sont prises.

- Sensibilisation et éducation du public: Les systèmes d’IA font l’objet de nombreux mythes. L’un des moyens de répondre à ces préoccupations est d’éduquer le public sur les technologies de l’IA, leurs capacités et leurs limites.

- Approche collaborative: Ces préoccupations ne se limitent pas à une industrie ou à une section particulière de la société. En tant que telles, les mesures prises pour résoudre les problèmes doivent adopter une approche collaborative impliquant les décideurs politiques, le public et les développeurs.

Il s’agit d’une technologie encore à l’état brut, qui met à rude épreuve les limites éthiques et juridiques. Il est essentiel pour l’avenir et le développement de l’IA de répondre aux préoccupations liées aux boîtes noires de l’IA.

Les boîtes noires de l’IA : Un dilemme éthique

Les boîtes noires d’IA sont porteuses de promesses et d’opportunités considérables, mais il y a des défis à relever. Il ne fait aucun doute que l’IA est là pour durer. L’adoption rapide de cette technologie a fait d’elle une partie intégrante de nos vies. Mais le manque de transparence et de responsabilité est une préoccupation réelle et urgente.

En créant plus de transparence et de responsabilité dans les modèles d’IA, les développeurs peuvent s’éloigner des « boîtes noires » pour passer à un modèle transparent dans sa prise de décision et les mesures prises pour y parvenir.

Qu’est-ce qu’une boîte noire de l’IA ?

L’IA boîte noire est un type d’intelligence artificielle (IA) si complexe que son processus de prise de décision ne peut pas être expliqué d’une manière facilement compréhensible par les humains. L’IA boîte noire est le contraire de l’IA explicable (XAI).

Quel est l’exemple d’une boîte noire en IA ?

Si, par exemple, un véhicule autonome heurte un piéton alors que nous nous attendrions à ce qu’il freine, la nature de boîte noire du système signifie que nous ne pouvons pas retracer le processus de pensée du système et voir pourquoi il a pris cette décision.

Comment fonctionne un modèle de boîte noire ?

Dans le domaine de l’intelligence artificielle, un modèle de boîte noire utilise un algorithme d’apprentissage automatique pour faire des prédictions alors que l’explication de cette prédiction reste inconnue et introuvable. Un modèle de boîte blanche tente d’intégrer des contraintes qui rendent le processus d’apprentissage automatique plus transparent.

Comment utiliser l’IA boîte noire ?

L’application web Blackbox est conçue pour vous permettre de transformer n’importe quelle question en code et vous faire gagner plus de 5 heures par semaine en tant que développeur de logiciels. Allez sur useblackbox.io/search et tapez votre question dans la boîte de recherche. Remarque : il est important de préciser le langage de programmation dans vos questions.