Qu’est-ce que l’hallucination de l’IA et comment la repérer ?

L’hallucination liée à l’intelligence artificielle (IA) peut laisser perplexe. Vous vous dites probablement : « L’hallucination n’est-elle pas un phénomène humain ? » Eh bien, oui, c’était un phénomène exclusivement humain jusqu’à ce que l’IA commence à présenter des caractéristiques humaines telles que la reconnaissance faciale, l’auto-apprentissage et la reconnaissance vocale.

Malheureusement, l’IA s’est dotée de certains attributs négatifs, dont les hallucinations. L’hallucination de l’IA est-elle donc similaire au type d’hallucination dont les humains font l’expérience ?

Qu’est-ce que l’hallucination de l’IA ?

L’hallucination de l’intelligence artificielle se produit lorsqu’un modèle d’intelligence artificielle génère des résultats différents de ceux attendus. Il convient de noter que certains modèles d’IA sont entraînés à générer intentionnellement des résultats sans rapport avec les données d’entrée du monde réel.

Par exemple, les meilleurs générateurs de texte-art de l’IA, tels que DALL-E 2, peuvent générer de manière créative de nouvelles images que nous pouvons qualifier d' »hallucinations » puisqu’elles ne sont pas basées sur des données du monde réel.

Hallucination de l’IA dans les grands modèles de traitement du langage

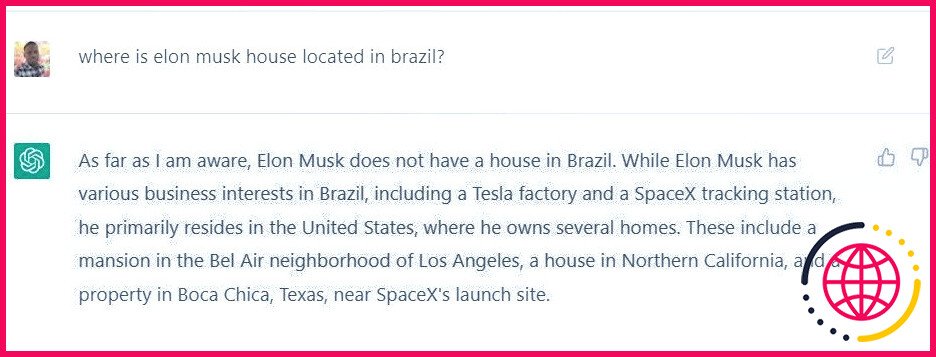

Voyons à quoi ressemblerait une hallucination de l’IA dans un grand modèle de traitement du langage tel que ChatGPT. Une hallucination de ChatGPT résulterait du fait que le robot vous donnerait un fait incorrect accompagné d’une affirmation, de telle sorte que vous prendriez naturellement ces faits pour des vérités.

En termes simples, il s’agit d’affirmations inventées par le chatbot artificiellement intelligent. Voici un exemple :

En demandant plus d’informations, ChatGPT a trouvé ceci :

L’hallucination de l’IA dans la vision par ordinateur

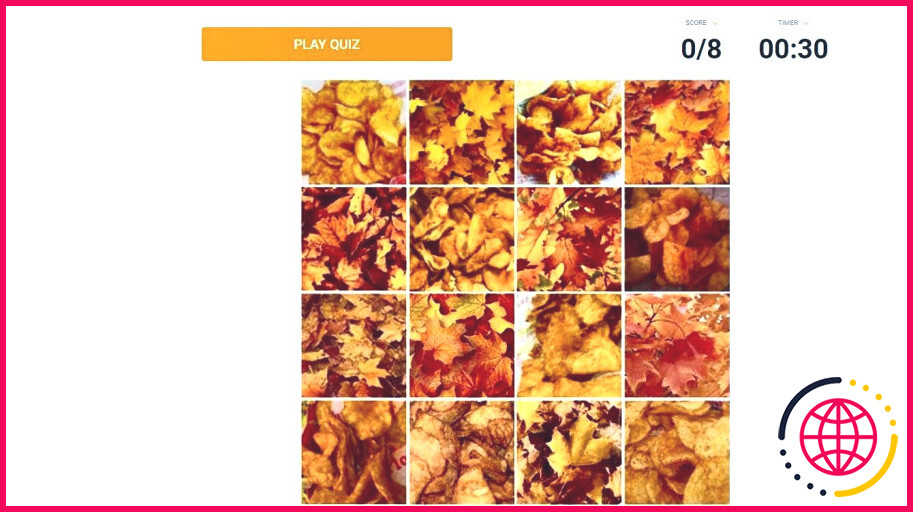

Examinons un autre domaine de l’IA qui peut connaître l’hallucination de l’IA : La vision par ordinateur. Le quiz ci-dessous montre un montage 4×4 avec deux entités qui se ressemblent beaucoup. Les images sont un mélange de chips BBQ et de feuilles.

Le défi consiste à sélectionner les chips sans toucher les feuilles dans le montage. Cette image pourrait sembler délicate à un ordinateur, et il pourrait être incapable de faire la différence entre les chips BBQ et les feuilles.

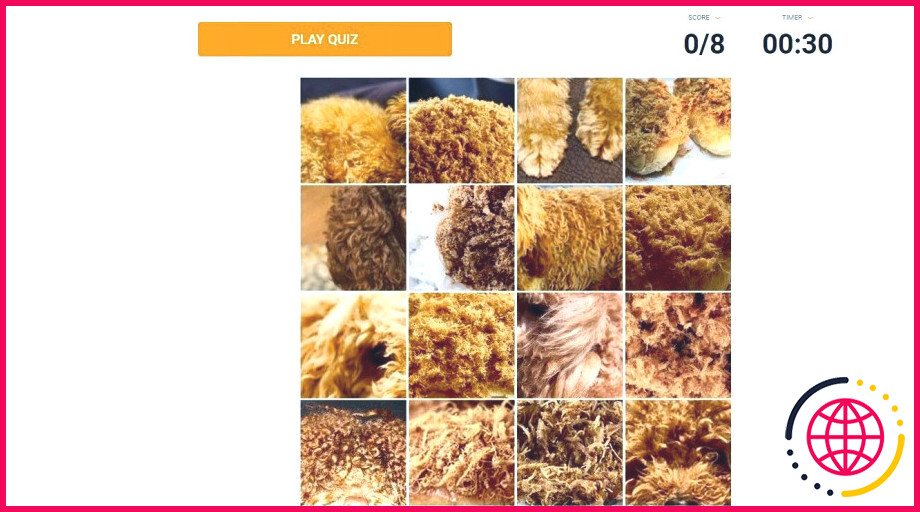

Voici un autre montage avec un mélange d’images de caniches et de brioches de porc. Un ordinateur serait probablement incapable de les différencier, c’est pourquoi les images sont mélangées.

Pourquoi les hallucinations de l’IA se produisent-elles ?

L’hallucination de l’IA peut être due à des exemples contradictoires, c’est-à-dire des données d’entrée qui trompent une application d’IA en la classant de manière erronée. Par exemple, lors de la formation des applications d’IA, les développeurs utilisent des données (images, textes ou autres) ; si les données sont modifiées ou déformées, l’application interprète l’entrée différemment, produisant un résultat erroné.

En revanche, un humain peut toujours reconnaître et identifier les données avec précision malgré les distorsions. On peut parler de bon sens, un attribut humain que l’IA ne possède pas encore. Regardez comment l’IA est trompée avec des exemples contradictoires dans cette vidéo :

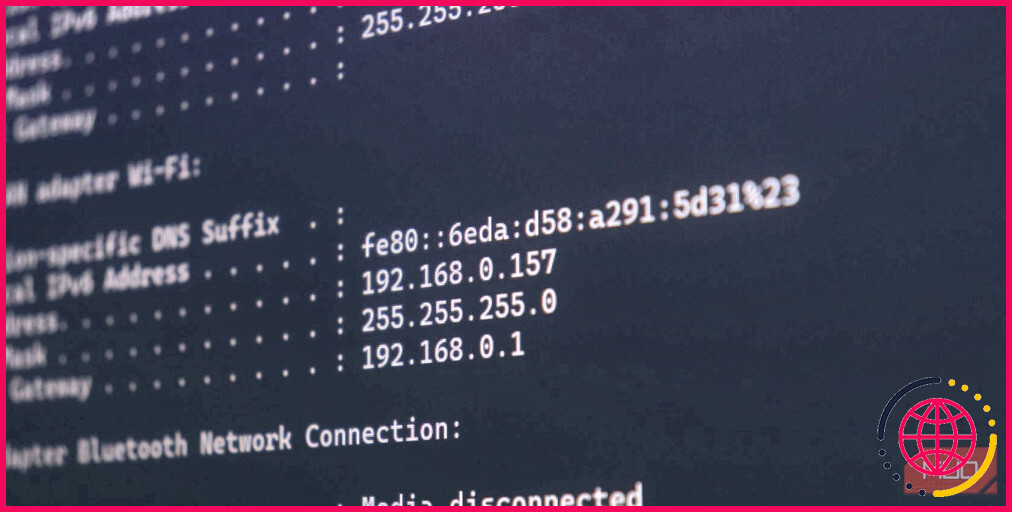

En ce qui concerne les grands modèles basés sur la langue, tels que ChatGPT et ses alternatives, les hallucinations peuvent provenir d’un décodage imprécis du transformateur (modèle d’apprentissage automatique).

En IA, un transformateur est un modèle d’apprentissage profond qui utilise l’auto-attention (relations sémantiques entre les mots d’une phrase) pour produire un texte similaire à ce qu’un humain écrirait en utilisant une séquence codeur-décodeur (entrée-sortie).

Ainsi, les transformateurs, un modèle d’apprentissage automatique semi-supervisé, peuvent générer un nouveau corps de texte (sortie) à partir du grand corpus de données textuelles utilisé dans sa formation (entrée). Pour ce faire, il prédit le mot suivant d’une série en se basant sur les mots précédents.

En ce qui concerne l’hallucination, si un modèle de langage a été formé à partir de données et de ressources insuffisantes et inexactes, on peut s’attendre à ce que les résultats soient inventés et inexacts. Le modèle de langage peut générer une histoire ou un récit sans incohérences logiques ou sans liens clairs.

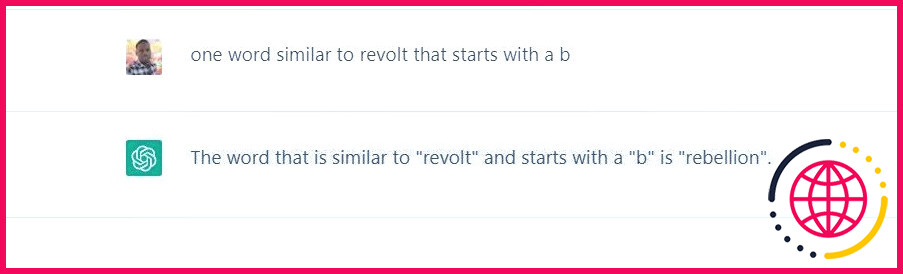

Dans l’exemple ci-dessous, on a demandé à ChatGPT de donner un mot similaire à « révolte » et commençant par un « b ». Voici sa réponse :

En approfondissant, il a continué à donner des réponses erronées, avec un niveau de confiance élevé.

Pourquoi ChatGPT est-il incapable de donner une réponse précise à ces questions ?

Il se peut que le modèle de langage ne soit pas équipé pour traiter des invites plutôt complexes comme celles-ci ou qu’il ne puisse pas interpréter l’invite avec précision, en ignorant l’invitation à donner un mot similaire avec un alphabet spécifique.

Comment repérer une hallucination de l’IA ?

Il est désormais évident que les applications d’IA ont le potentiel d’halluciner, c’est-à-dire de générer des réponses différentes de celles attendues (faits ou vérité) sans aucune intention malveillante. C’est aux utilisateurs de ces applications qu’il appartient de repérer et de reconnaître les hallucinations de l’IA.

Voici quelques moyens de repérer les hallucinations de l’IA lors de l’utilisation d’applications d’IA courantes :

1. Les grands modèles de traitement du langage

Bien que cela soit rare, si vous remarquez une erreur grammaticale dans le contenu produit par un grand modèle de traitement, tel que ChatGPT, cela devrait vous faire sourciller et vous faire suspecter une hallucination. De même, lorsque le contenu généré par le texte ne semble pas logique, n’est pas en corrélation avec le contexte donné ou ne correspond pas aux données d’entrée, vous devez suspecter une hallucination.

L’utilisation du jugement humain ou du bon sens peut aider à détecter les hallucinations, car les humains peuvent facilement identifier lorsqu’un texte n’a pas de sens ou ne correspond pas à la réalité.

2. La vision par ordinateur

En tant que branche de l’intelligence artificielle, de l’apprentissage automatique et de l’informatique, la vision par ordinateur permet aux ordinateurs de reconnaître et de traiter les images comme des yeux humains. En utilisant des réseaux neuronaux convolutifs, ils s’appuient sur l’incroyable quantité de données visuelles utilisées dans leur formation.

Un écart par rapport aux schémas des données visuelles utilisées dans la formation entraînera des hallucinations. Par exemple, si un ordinateur n’a pas été entraîné avec des images d’une balle de tennis, il pourrait l’identifier comme une orange verte. Ou si un ordinateur reconnaît un cheval à côté d’une statue humaine comme un cheval à côté d’un vrai humain, alors une hallucination de l’IA s’est produite.

Pour repérer une hallucination de vision par ordinateur, il faut donc comparer le résultat généré à ce qu’un être humain est censé voir.

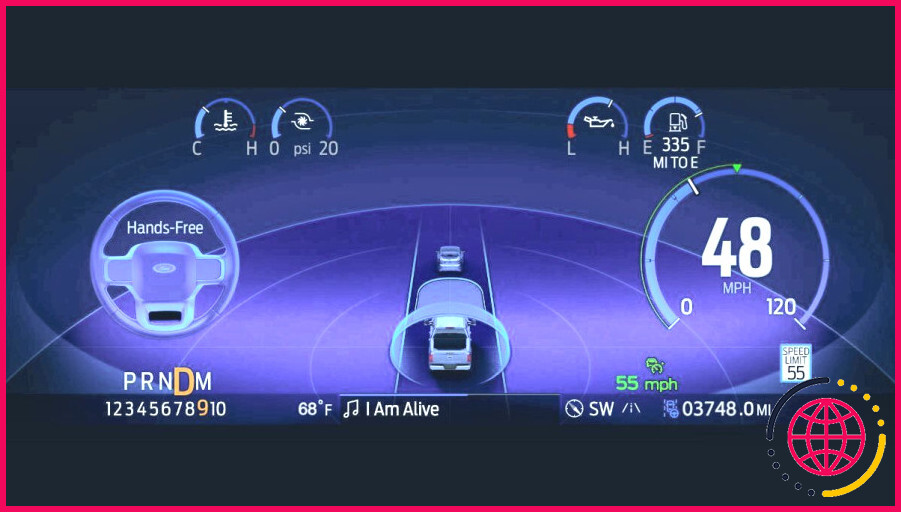

3. Les voitures auto-conduites

Grâce à l’IA, les voitures autonomes s’infiltrent progressivement sur le marché de l’automobile. Des pionniers comme l’Autopilot de Tesla et le BlueCruise de Ford ont défendu la scène des voitures auto-conduites. Vous pouvez vérifier comment et ce que l’Autopilot de Tesla voit pour avoir une idée de la façon dont l’IA alimente les voitures autopilotées.

Si vous possédez l’une de ces voitures, vous voudrez savoir si votre voiture à IA a des hallucinations. L’un des signes sera que votre véhicule semble s’écarter de son comportement normal pendant la conduite. Par exemple, si le véhicule freine ou fait une embardée soudaine sans raison évidente, il se peut que votre voiture IA soit en proie à des hallucinations.

Les systèmes d’IA peuvent aussi halluciner

Les humains et les modèles d’IA ne vivent pas les hallucinations de la même manière. En ce qui concerne l’IA, les hallucinations font référence à des résultats erronés qui sont à mille lieues de la réalité ou qui n’ont pas de sens dans le contexte de l’invite donnée. Par exemple, un chatbot d’IA peut donner une réponse grammaticalement ou logiquement incorrecte ou mal identifier un objet en raison du bruit ou d’autres facteurs structurels.

Les hallucinations de l’IA ne résultent pas d’un esprit conscient ou subconscient, comme c’est le cas chez les humains. Elles résultent plutôt de l’inadéquation ou de l’insuffisance des données utilisées pour la formation et la programmation du système d’IA.

S’abonner à la lettre d’information

Quel est un exemple d’hallucination de l’IA ?

Les utilisateurs se sont plaints que ces robots semblaient souvent intégrer de manière « sociopathique » et inutile des faussetés aléatoires et plausibles dans le contenu qu’ils généraient. Un autre exemple d’hallucination dans l’intelligence artificielle est lorsque l’IA ou le chatbot oublient qu’ils en sont un et prétendent être humains.

Qu’est-ce qui fait qu’une personne voit des choses qui n’existent pas ?

Une hallucination consiste à voir, entendre, sentir ou goûter quelque chose qui n’existe pas réellement. Les hallucinations peuvent être le résultat de problèmes de santé mentale tels que la maladie d’Alzheimer, la démence ou la schizophrénie, mais elles peuvent également être causées par d’autres choses, comme l’alcool ou les drogues.

Que sont les chatbots hallucinants ?

On parle d’hallucination dans les chatbots d’IA lorsqu’une machine fournit des réponses convaincantes mais complètement inventées, a expliqué M. Raghavan. Il ne s’agit pas d’un phénomène nouveau et des développeurs ont mis en garde contre des modèles d’IA convaincus de faits totalement faux, répondant à des requêtes par des réponses inventées.

Comment aider une personne qui a des hallucinations ?

Une personne qui a des hallucinations peut être très effrayée par celles-ci et a besoin de votre aide pour établir un environnement calme. N’envahissez pas son espace personnel et ne la touchez pas sans sa permission. Parlez lentement, calmement et doucement, en utilisant un langage simple et concret. Soyez patient – la personne peut avoir besoin de plus de temps pour assimiler l’information.