Comment se présente le flux d’air pour les dags ?

À quoi ressemble le flux d’air pour les dags ?

Lorsque vous regardez à quoi ressemble le flux d’air pour les dags, vous voudrez tenir compte de la direction du flux d’air et de la vitesse du flux d’air. La direction du flux d’air est importante car vous voulez vous assurer que l’air circule dans la bonne direction afin qu’il puisse circuler correctement dans toute la pièce. La vitesse du flux d’air est également importante car vous voulez vous assurer que l’air se déplace assez rapidement pour garder la pièce fraîche.

Airflow recherche dans votre DAGS_FOLDER les modules qui contiennent des objets DAG dans leur espace de noms global et ajoute les objets qu’il trouve dans le DagBag . Sachant cela, tout ce dont nous avons besoin est un moyen d’assigner dynamiquement une variable dans l’espace de noms global.

Comment airflow stocke-t-il les DAGs ?

Base de données de métadonnées Apache Airflow :

La base de données de métadonnées stocke les configurations, telles que les variables et les connexions. Elle stocke également les informations sur les utilisateurs, les rôles et les politiques. Enfin, le planificateur analyse tous les DAG et stocke les métadonnées pertinentes telles que les intervalles de planification, les statistiques de chaque exécution et leurs tâches.

À quelle fréquence airflow vérifie-t-il la présence de nouveaux DAG ?

Vous pouvez configurer votre service de planificateur pour qu’il redémarre toutes les quelques minutes, il devrait capter de nouveaux DAG après avoir été redémarré. Il suffit d’utiliser airflow scheduler -r 300 , cela signifie que le planificateur sort toutes les 300 secondes, donc si vous configurez votre service pour toujours redémarrer le planificateur, chaque nouveau dag devrait être chargé dans les 300 secondes. < 5 minutes.

Comment déployer des DAGs dans airflow ?

Lorsque votre nouveau fichier DAG est chargé dans Airflow, vous pouvez le reconnaître dans l’interface utilisateur grâce au numéro de version. Parce que votre nom de fichier DAG = DAG Id, vous pourriez même améliorer le script de déploiement en ajoutant une certaine ligne de commande Airflow pour allumer automatiquement vos nouveaux DAG une fois qu’ils sont déployés.

Quand ne devriez-vous pas utiliser Airflow ?

Un échantillon d’exemples qu’Airflow ne peut pas satisfaire de manière de première classe comprend :

- Les DAGs qui doivent être exécutés hors calendrier ou sans calendrier du tout.

- DAGs qui s’exécutent simultanément avec la même heure de début.

- DAGs avec une logique de branchement compliquée.

- DAGs avec de nombreuses tâches rapides.

- DAGs qui reposent sur l’échange de données.

Qu’est-ce qu’un cluster dans Airflow ?

Un cluster Apache Airflow typique

Un démon qui accepte les requêtes HTTP et vous permet d’interagir avec Airflow via une application Web Python Flask. Il offre la possibilité de mettre en pause, de mettre en pause les DAGs, de déclencher manuellement les DAGs, de visualiser les DAGs en cours d’exécution, de redémarrer les DAGs en échec et bien plus encore.

Comment puis-je savoir si mon Airflow fonctionne ?

Pour vérifier l’état de santé de votre instance Airflow, vous pouvez simplement accéder au point de terminaison /health . Il retournera un objet JSON dans lequel un aperçu de haut niveau est fourni.

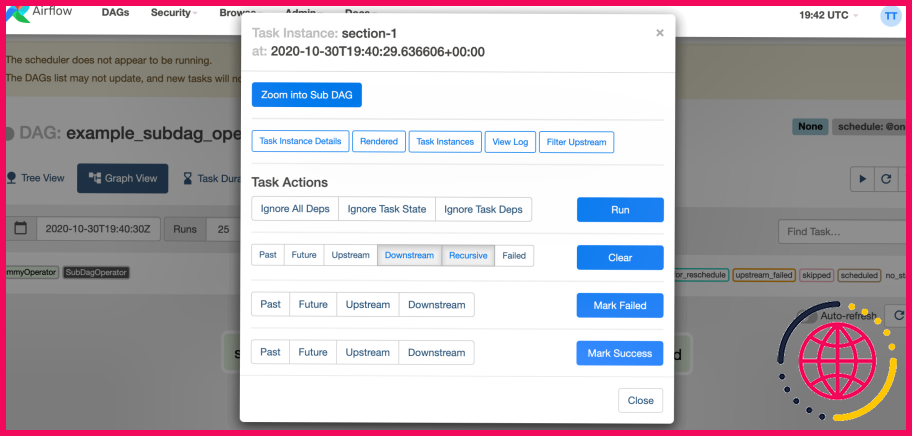

Comment puis-je exécuter manuellement Airflow DAG ?

Lorsque vous rechargez l’interface utilisateur Airflow dans votre navigateur, vous devriez voir votre DAG hello_world listé dans l’interface utilisateur Airflow. Afin de lancer une exécution DAG, activez d’abord le flux de travail (flèche 1), puis cliquez sur le bouton Trigger Dag (flèche 2) et enfin, cliquez sur la vue graphique (flèche 3) pour voir la progression de l’exécution.

Comment puis-je savoir quelle version d’Airflow je possède ?

Sur Airflow

Que vous développiez localement ou sur Astronomer Cloud, vous pouvez vérifier votre version d’Airflow en : Se connectant à l’interface utilisateur d’Airflow. Naviguez vers À propos de > Version.

Airflow est-il un outil ETL ?

Airflow n’est pas un outil ETL en soi. Mais il gère, structure et organise les pipelines ETL en utilisant quelque chose appelé les graphes acycliques dirigés (DAGs). La base de données de métadonnées stocke les workflows/tâches (DAGs).

Qu’est-ce que le planificateur Airflow ?

Le planificateur Airflow surveille toutes les tâches et les DAGs, puis déclenche les instances de tâches une fois que leurs dépendances sont terminées. L’ordonnanceur Airflow est conçu pour fonctionner comme un service persistant dans un environnement de production Airflow. Pour le lancer, il suffit d’exécuter la commande airflow scheduler.

Quelle base de données Airflow utilise-t-il ?

Choix du backend de la base de données.

Par défaut, Airflow utilise SQLite, qui est destiné à des fins de développement uniquement. Airflow supporte les versions suivantes du moteur de base de données, donc assurez-vous de la version que vous avez.

Où se trouve le CFG d’airflow ?

La première fois que vous exécutez Airflow, il créera un fichier appelé airflow. cfg dans votre répertoire $AIRFLOW_HOME ( ~/airflow par défaut). Ce fichier contient la configuration d’Airflow et vous pouvez le modifier pour changer n’importe lequel des paramètres.

Comment exécuter airflow dans le planificateur d’arrière-plan ?

Sur un serveur : Peut utiliser –daemon pour s’exécuter comme démon : airflow scheduler –daemon Ou, peut-être s’exécuter en arrière-plan : airflow scheduler. >& log. txt & Ou encore, exécutez dans ‘screen’ comme ci-dessus, puis détachez de l’écran en utilisant ctrl-a d, rattachez si nécessaire en utilisant ‘screen -r’. Cela fonctionnerait sur une connexion ssh.

Comment puis-je supprimer les journaux d’airflow ?

Pour nettoyer les fichiers journaux de l’ordonnanceur, je les supprime manuellement deux fois dans une semaine pour éviter le risque de suppression des journaux qui doit être nécessaire pour certaines raisons. Je nettoie les fichiers de logs par [sudo rm -rd airflow/logs/] commande.

Comment passer des arguments à Airflow DAG ?

Vous pouvez passer des paramètres à partir de la CLI en utilisant –conf ‘ »key » : « value »‘ et ensuite l’utiliser dans le fichier DAG comme » dag_run. conf.[« key »] » dans le champ modèle.

Comment arrêter le DAG Airflow ?

Vous pouvez arrêter un dag (le démarquer comme étant en cours d’exécution) et effacer les états des tâches ou même les supprimer dans l’interface utilisateur. Les tâches en cours d’exécution dans l’exécuteur ne s’arrêteront pas, mais pourraient être tuées si l’exécuteur réalise qu’il n’est plus dans la base de données. «

Qu’est-ce que le catchup faux dans Airflow ?

Remarque : Sur la base de vos configurations Airflow, il ne générera que X exécutions de DAG à la fois. Cela peut être évité en définissant catchup=False (par défaut, il est défini sur True ), ce qui indique au planificateur de ne pas faire en sorte que les exécutions DAG « rattrapent » la date actuelle. Voir la documentation. Remarque : catchup peut être défini à False par défaut dans airflow.cfg.

Airflow utilise-t-il Redis ?

Le serveur web d’Airflow et son ordonnanceur vont partager le même conteneur. Nous allons utiliser des images docker disponibles publiquement pour Postgres et Redis. Les deux conteneurs seront utilisés pour les nœuds de travail et le dernier conteneur sera dédié à la surveillance des nœuds de travail.

Comment mettre à jour Airflow ?

- Étape 1 : Passez à Python 3.

- Étape 2 : mettez à jour vers la version 1.10.15.

- Étape 3 : Exécutez les scripts de vérification de la mise à niveau.

- Étape 4 : Passez aux fournisseurs de backport.

- Étape 5 : Mettez à niveau les DAGs Airflow.

- Étape 6 : Mise à niveau des paramètres de configuration.

- Étape 7 : Mise à niveau vers Airflow 2.

- Annexe. Paramètres modifiés pour le KubernetesPodOperator.

Comment redémarrer mon ordonnanceur Airflow ?

Comment puis-je redémarrer les services Airflow ? Vous pouvez effectuer des actions de démarrage/arrêt/redémarrage sur un service Airflow et les commandes utilisées pour chaque service sont indiquées ci-dessous : Exécuter sudo monit

Comment faire un cluster Airflow ?

Etapes

- Installez Apache Airflow sur TOUTES les machines qui auront un rôle dans l’Airflow.

- Déployez vos DAGs/Workflows sur master1 et master2 (et tout autre nœud master futur que vous pourriez ajouter).

- Sur master1, initialiser la base de données Airflow (si ce n’est pas déjà fait après avoir mis à jour la configuration sql_alchemy_conn) airflow initdb.

Qu’est-ce que celery Airflow ?

airflow celery worker. Votre worker devrait commencer à ramasser les tâches dès qu’elles sont tirées dans sa direction. Pour arrêter un worker fonctionnant sur une machine, vous pouvez utiliser : airflow celery stop. Il essaiera d’arrêter le worker gracieusement en envoyant le signal SIGTERM au processus principal de Celery comme recommandé par la documentation de Celery.

Comment exécuter Airflow sur Kubernetes ?

Airflow avec Kubernetes

- RUN pip install –upgrade pip RUN pip install apache-airflow==1.10.10 RUN pip install ‘apache-airflow’.[kubernetes]’ .

- si [« $1 » = « webserver »] then exec airflow webserver fi if [« $1 » = « scheduler »] then execute airflow scheduler fi.

Comment contourner le CFG d’airflow ?

Vous pouvez contourner les paramètres du fichier de configuration airflow. cfg en fournissant des variables d’environnement qui correspondent au format suivant : AIRFLOW__