Beautiful Soup vs. Scrapy vs. Selenium : Quel outil de scraping web utiliser ?

Vous voulez découvrir le web scuffing avec Python mais vous ne savez pas si vous devez utiliser Beautiful Soup, Selenium ou Scrapy pour votre prochain projet ? Bien que toutes ces bibliothèques et aussi structures Python soient efficaces en soi, elles ne répondent pas à toutes les exigences en matière de scraping internet, et aussi, il est vital de reconnaître quel outil vous devez utiliser pour une tâche particulière.

Jetons un coup d’œil aux distinctions entre Beautiful Soup, Scrapy et Selenium, afin que vous puissiez faire un choix judicieux avant de commencer votre prochain projet de grattage internet en Python.

1. Facilité d’utilisation

Si vous êtes un novice, votre demande initiale serait certainement une bibliothèque simple à découvrir et à utiliser. Attractive Soup vous utilise tous les outils rudimentaires dont vous avez besoin pour gratter l’internet, et elle est spécifiquement précieuse pour les personnes qui ont une expérience minimale de Python mais qui veulent se lancer dans le grattage du web.

Le seul bémol est que, en raison de sa simplicité, Beautiful Soup n’est pas aussi puissant que Scrapy ou Selenium. Les concepteurs ayant une expérience de croissance peuvent rapidement comprendre Scrapy ainsi que Selenium, mais pour les débutants, la tâche initiale peut prendre beaucoup de temps à construire s’ils choisissent d’aller avec ces structures au lieu de Beautiful Soup.

Pour récupérer le contenu web de la balise title sur exemple.com en utilisant Beautiful Soup, vous utiliserez certainement le code suivant :

Pour obtenir des résultats similaires en utilisant Selenium, vous écrirez certainement :

Le cadre de données d’une tâche Scrapy comprend plusieurs données, ce qui ajoute à sa complexité. Le code suivant extrait le titre d’exemple.com :

Si vous souhaitez retirer des informations d’un service qui fournit une API officielle, il peut être judicieux d’utiliser l’API plutôt que de créer un scrape web.

2. Vitesse de grattage et aussi parallélisation.

Parmi les 3, Scrapy est le champion incontesté lorsqu’il s’agit de vitesse de grattage. C’est parce qu’il soutient la parallélisation par défaut. En utilisant Scrapy, vous pouvez envoyer plusieurs demandes HTTP en même temps, ainsi que lorsque le manuscrit a téléchargé et installé le code HTML pour la collection initiale de demandes, il est prêt à envoyer un autre ensemble.

Avec Beautiful Soup, vous pouvez faire usage de la bibliothèque de threading pour envoyer des demandes HTTP simultanées, cependant ce n’est pas pratique et aussi vous devrez apprendre le multithreading pour le faire. Sur Selenium, il est impossible de réaliser la parallélisation sans lancer de nombreuses instances de navigateur.

Si vous deviez classer ces 3 dispositifs d’éraflage d’internet par rapport à la vitesse, Scrapy est le plus rapide, suivi de Beautiful Soup et aussi de Selenium.

3. Utilisation de la mémoire

Selenium est une API d’automatisation de navigateur, qui a effectivement situé ses applications dans le domaine de l’érosion de l’internet. Lorsque vous utilisez Selenium pour gratter un site, il génère une circonstance de navigateur sans cerveau qui s’exécute dans l’historique. Cela fait de Selenium un outil gourmand en ressources par rapport à Beautiful Soup et Scrapy.

Comme ces derniers fonctionnent entièrement en ligne de commande, ils utilisent moins de sources système et font preuve d’une bien meilleure efficacité que Selenium.

4. Exigences de dépendance

Beautiful Soup est une collection d’outils d’analyse syntaxique qui vous aident à retirer des informations des documents HTML ainsi que des documents XML. Il est livré avec absolument rien d’autre. Vous devez utiliser des collections comme demandes ou urllib pour faire des demandes HTTP, des parsers intégrés pour analyser le HTML/XML, et des collections ajoutées pour implémenter des proxies ou le support de bases de données.

Scrapy, d’un autre côté, présente tout le toutim. Vous obtenez des dispositifs pour envoyer des requêtes, analyser le code téléchargé et installé, faire des procédures sur les informations retirées, et aussi conserver les informations éraflées. Vous pouvez ajouter diverses autres performances à Scrapy en utilisant des expansions et aussi des middleware, mais cela viendrait plus tard.

Avec Selenium, vous téléchargez et installez un moteur internet pour le navigateur internet que vous voulez automatiser. Pour mettre en œuvre diverses autres fonctions comme l’espace de stockage d’informations ainsi que le support des proxy, vous auriez certainement besoin de modules tiers.

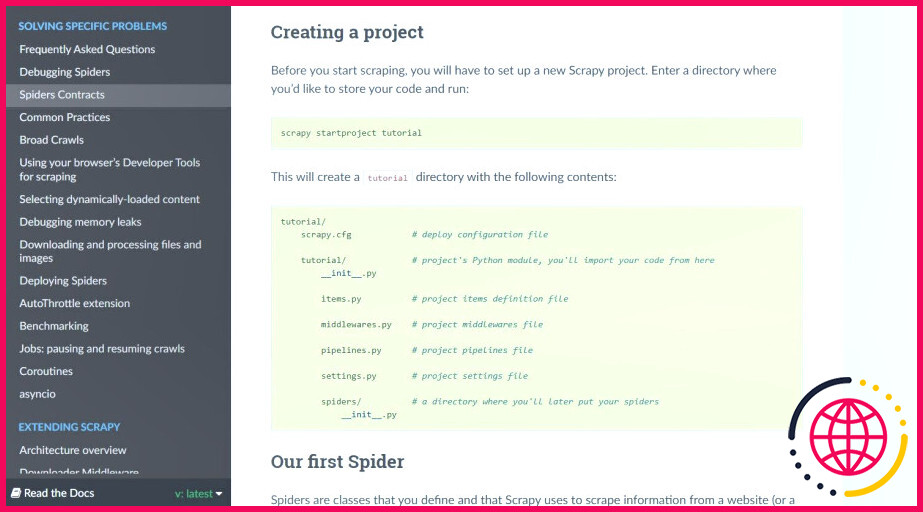

5. Qualité de la documentation

Dans l’ensemble, chaque document de la tâche est bien structuré et décrit chaque méthode en utilisant des instances. Mais l’efficacité des documents d’une tâche dépend grandement du visiteur également.

La paperasse de Beautiful Soup est meilleure pour les novices qui débutent dans le domaine du web. Selenium et Scrapy ont effectivement une documentation décrite, sans aucun doute, mais le jargon technique peut prendre de nombreux débutants au dépourvu.

Si vous êtes expérimenté avec les principes et les termes des programmes, après cela, l’un ou l’autre des trois documents serait certainement un jeu d’enfant à vérifier.

6. Prise en charge des extensions et également des intergiciels

Scrapy est le framework Python de scraping internet le plus extensible, durée. Il supporte les middleware, les extensions, les proxies, et aussi beaucoup plus, ainsi que des aides vous créer un crawler pour les travaux massifs.

Vous pouvez écrire des crawlers infaillibles et fiables en appliquant des middlewares dans Scrapy, qui sont essentiellement des crochets qui ajoutent des fonctionnalités personnalisées au système par défaut du framework. À titre d’exemple, le HttpErrorMiddleware s’occupe des erreurs HTTP afin que les crawlers n’aient pas à les gérer pendant le traitement des requêtes.

Les middleware ainsi que les extensions sont uniques à Scrapy cependant vous pouvez obtenir des résultats similaires avec Beautiful Soup et aussi Selenium en utilisant des bibliothèques Python supplémentaires.

7. Rendu JavaScript

Selenium a un cas d’utilisation où il surpasse diverses autres bibliothèques de grattage Web, et c’est le grattage des sites Web compatibles JavaScript. Bien que vous puissiez gratter des composants JavaScript à l’aide de middlewares Scrapy, les opérations de Selenium sont les plus faciles et aussi les plus pratiques de toutes.

Vous utilisez un navigateur pour emballer un site Web, vous vous engagez avec lui en utilisant des clics et aussi des pressions de commutateur, et aussi quand vous avez le contenu que vous avez besoin de gratter sur l’affichage, le retirer en utilisant les CSS de Selenium ainsi que les sélecteurs XPath.

Beautiful Soup peut sélectionner des éléments HTML à l’aide de sélecteurs XPath ou CSS. Il ne fournit pas la capacité de gratter les aspects rendus par JavaScript sur un site Web, cependant.

Web Scraping Made Easy With Python (en anglais)

Le web contient beaucoup d’informations brutes. Le grattage d’Internet aide à convertir ces informations directement en informations utiles qui peuvent être placées à un excellent usage. Selenium est très probablement votre pari le plus sûr si vous avez l’intention de scraper un site Internet avec JavaScript ou si vous avez besoin de provoquer certains éléments à l’écran avant d’extraire les données.

Scrapy est un framework de grattage internet complet pour toutes vos demandes, que vous ayez l’intention de créer un petit spider ou un grand scrape qui rampe constamment sur internet pour trouver des informations mises à jour.

Vous pouvez utiliser Beautiful Soup si vous êtes un débutant ou si vous avez besoin d’établir rapidement un scraper. Quelle que soit la structure ou la bibliothèque avec laquelle vous allez, il est très facile de commencer à apprendre le scraping internet avec Python.

Abonnez-vous à notre e-newsletter

Selenium ou Beautiful Soup sont-ils meilleurs pour le scraping web ?

Selenium est à l’aise pour scrapper des pages relativement plus complexes et dynamiques, au prix d’un coût de ressources informatiques plus élevé. Beautiful Soup est plus facile à prendre en main, et bien que plus limité dans les sites web qu’il peut scrapper, il est idéal pour les petits projets où les pages sources sont bien structurées.

Beautiful Soup est-il meilleur que Scrapy ?

‘Beautiful Soup’ peut aider à extraire des éléments spécifiques d’une page web cible, tandis que ‘Scrapy’ peut gérer la récupération asynchrone des données, ce qui augmente l’efficacité.

Beautiful Soup est-il meilleur que Selenium ?

Si vous êtes un débutant et si vous voulez apprendre les choses rapidement et que vous voulez effectuer des opérations de web scraping, alors Beautiful Soup est le meilleur choix. Selenium : Lorsque vous avez affaire à Core Javascript site web featured alors Selenium serait le meilleur choix.

Quelles sont les limites de Beautiful Soup ?

Inconvénients de l’utilisation de BeautifulSoup Beaucoup de dépendances : En tant que parseur, BeautifulSoup ne peut pas fonctionner tout seul. Vous devez installer des dépendances pour utiliser l’outil. Lenteur : BeautifulSoup peut être lent lorsqu’il est utilisé avec des dépendances, notamment par rapport à Scrapy et à d’autres solutions complètes.