5 choses à ne pas partager avec les chatbots IA

Les chatbots d’IA générative sont extraordinaires, mais nous ne pouvons pas prétendre qu’ils sont sans faille. Alors que nous utilisons de plus en plus l’IA, il est extrêmement important de comprendre qu’il vaut mieux garder certaines informations privées et ne jamais les partager avec un chatbot d’IA.

Les risques pour la vie privée des chatbots d’IA

Les chatbots d’IA tels que ChatGPT et Gemini de Google sont populaires parce qu’ils peuvent générer des réponses semblables à celles des humains. Cependant, leur dépendance à l’égard des grands modèles de langage (LLM) s’accompagne de risques pour la vie privée et la sécurité. Ces vulnérabilités mettent en évidence la manière dont les informations personnelles partagées au cours des interactions pourraient être exposées ou utilisées à mauvais escient.

- Pratiques de collecte de données : Les chatbots d’IA utilisent de vastes données de formation, qui peuvent inclure des interactions avec les utilisateurs. Des entreprises comme OpenAI permettent aux utilisateurs de refuser la collecte de données, mais il peut s’avérer difficile de garantir une protection totale de la vie privée.

- Vulnérabilités des serveurs : Les données stockées par les utilisateurs sont susceptibles d’être piratées, les cybercriminels pouvant voler et utiliser ces informations à des fins malveillantes.

- Accès de tiers : Les données issues des interactions avec les chatbots peuvent être partagées avec des fournisseurs de services tiers ou consultées par le personnel autorisé, ce qui augmente le risque de violation.

- Pas d’utilisation publicitaire (prétendue) : Bien que les entreprises affirment ne pas vendre les données à des fins de marketing, elles sont partagées pour la maintenance du système et à des fins opérationnelles.

- Préoccupations relatives à l’IA générative : Les critiques affirment que l’adoption croissante de l’IA générative pourrait exacerber ces risques pour la sécurité et la vie privée.

Si vous souhaitez protéger vos données lors de l’utilisation de ChatGPT et d’autres chatbots d’IA, il convient de comprendre les risques liés à la protection de la vie privée. Bien que des entreprises comme OpenAI offrent une certaine transparence et un certain contrôle, la complexité du partage des données et les vulnérabilités en matière de sécurité requièrent de la vigilance.

Pour garantir votre confidentialité et votre sécurité, il existe cinq types de données clés que vous ne devez jamais partager avec un chatbot d’IA générative.

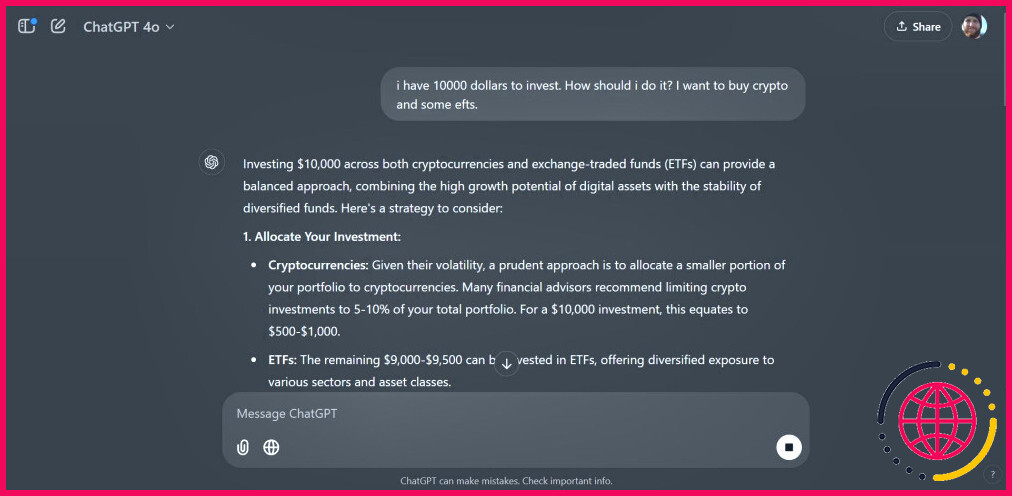

1. Détails financiers

Avec l’utilisation généralisée des chatbots d’IA, de nombreux utilisateurs se sont tournés vers ces modèles de langage pour obtenir des conseils financiers et gérer leurs finances personnelles. Bien qu’ils puissent améliorer la littératie financière, il est crucial de connaître les dangers potentiels liés au partage de détails financiers avec les chatbots d’IA.

Lorsque vous utilisez des chatbots comme conseillers financiers, vous risquez d’exposer vos informations financières à d’éventuels cybercriminels qui pourraient les exploiter pour vider vos comptes. Bien que les entreprises prétendent anonymiser les données de conversation, des tiers et certains employés peuvent toujours y avoir accès. Par exemple, un chatbot peut analyser vos habitudes de consommation pour vous donner des conseils, mais si des entités non autorisées accèdent à ces données, elles pourraient être utilisées pour établir votre profil en vue d’escroqueries, comme des courriels d’hameçonnage imitant votre banque.

Pour protéger vos informations financières, limitez vos interactions avec les chatbots d’IA à des informations générales et à des questions d’ordre général. Le fait de partager les détails d’un compte spécifique, l’historique des transactions ou les mots de passe peut vous rendre vulnérable. Un conseiller financier agréé est une option plus sûre et plus fiable si vous avez besoin de conseils financiers personnalisés.

2. Réflexions personnelles et intimes

De nombreux utilisateurs se tournent vers les chatbots d’IA pour suivre une thérapie, sans être conscients des conséquences potentielles pour leur bien-être mental. Il est essentiel de comprendre les dangers liés à la divulgation d’informations personnelles et intimes à ces chatbots.

Les chatbots d’IA manquent de connaissances du monde réel et ne peuvent offrir que des réponses génériques aux questions liées à la santé mentale. Cela signifie que les médicaments ou les traitements qu’ils suggèrent peuvent ne pas être adaptés à vos besoins spécifiques et pourraient nuire à votre santé.

En outre, le partage de pensées personnelles avec des chatbots d’IA soulève d’importants problèmes de protection de la vie privée. Votre vie privée peut être compromise car vos secrets et vos pensées intimes peuvent être divulgués en ligne ou utilisés dans le cadre des données d’entraînement de l’IA. Des personnes malveillantes pourraient exploiter ces informations pour vous espionner ou vendre vos données sur le dark web. Il est donc important de protéger la confidentialité des pensées personnelles lors de l’interaction avec les chatbots d’IA.

Les chatbots d’IA sont des outils d’information et de soutien généraux qui ne remplacent pas une thérapie professionnelle. Si vous avez besoin de conseils ou d’un traitement en matière de santé mentale, consultez un professionnel de la santé mentale qualifié. Ils peuvent fournir des conseils personnalisés et fiables tout en donnant la priorité à votre vie privée et à votre bien-être.

3. Informations confidentielles sur le lieu de travail

Une autre erreur que les utilisateurs doivent éviter lorsqu’ils interagissent avec des chatbots d’IA est de partager des informations confidentielles liées au travail. Des géants de la technologie tels qu’Apple, Samsung et Google ont interdit à leurs employés d’utiliser des chatbots d’IA sur le lieu de travail.

A Rapport de Bloomberg a mis en évidence un cas où des employés de Samsung ont utilisé ChatGPT à des fins de codage et ont téléchargé par inadvertance un code sensible sur la plateforme d’IA générative. Cet incident a entraîné la divulgation non autorisée d’informations confidentielles sur Samsung, ce qui a incité l’entreprise à interdire l’utilisation des chatbots d’IA. Si vous utilisez l’IA pour résoudre des problèmes de codage (ou tout autre problème sur le lieu de travail), vous ne devez pas confier d’informations confidentielles aux chatbots d’IA.

De même, de nombreux employés s’appuient sur des chatbots d’IA pour résumer les comptes rendus de réunions ou automatiser des tâches répétitives, ce qui présente un risque d’exposition involontaire de données sensibles. Vous pouvez sauvegarder les informations sensibles et protéger votre organisation contre les fuites involontaires ou les violations de données en étant conscient des risques associés au partage de données liées au travail.

4. Les mots de passe

Le partage de vos mots de passe en ligne, même avec de grands modèles linguistiques, est absolument à proscrire. Ces modèles stockent des données sur des serveurs et le fait de leur divulguer vos mots de passe met en péril votre vie privée.

Une importance importante impliquant ChatGPT s’est produite en mai 2022, soulevant des inquiétudes quant à la sécurité des plateformes de chatbot. En outre, ChatGPT a été interdit en Italie en raison du règlement général sur la protection des données (RGPD) de l’Union européenne. Les régulateurs italiens ont estimé que le chatbot d’IA n’était pas conforme aux lois sur la protection de la vie privée, soulignant les risques de violation des données sur la plateforme. L’interdiction a été levée depuis longtemps, mais elle illustre le fait que même si les entreprises ont renforcé les mesures de sécurité des données, les vulnérabilités persistent.

Pour protéger vos identifiants de connexion, ne les partagez jamais avec des chatbots, même à des fins de dépannage. Si vous devez réinitialiser ou gérer des mots de passe, utilisez des gestionnaires de mots de passe dédiés ou les protocoles informatiques sécurisés de votre organisation.

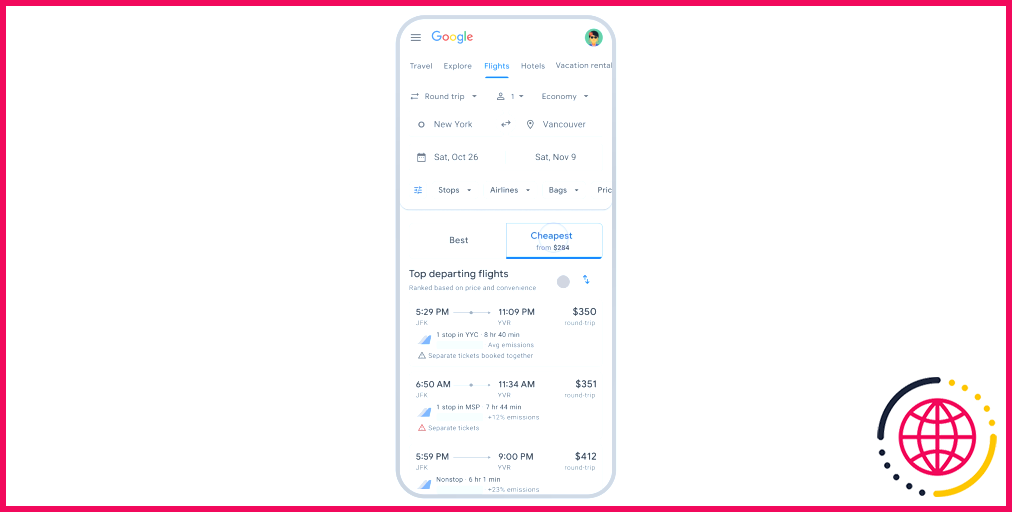

5. Détails résidentiels et autres données personnelles

À l’instar des médias sociaux et d’autres plateformes en ligne, vous ne devez pas partager d’informations d’identification personnelle (IPI) avec un chatbot d’IA. Les IPI comprennent des données sensibles telles que votre localisation, votre numéro de sécurité sociale, votre date de naissance et vos informations de santé, qui peuvent être utilisées pour vous identifier ou vous localiser. Par exemple, le fait de mentionner par hasard votre adresse personnelle en demandant à un chatbot des services à proximité pourrait vous exposer à des risques par inadvertance. Si ces données sont interceptées ou font l’objet d’une fuite, quelqu’un pourrait les utiliser pour usurper votre identité ou vous localiser dans le monde réel. De même, un partage excessif sur des plateformes intégrées à l’IA, comme Snapchat, pourrait involontairement révéler plus de choses sur vous que prévu.

Pour préserver la confidentialité de vos données lorsque vous vous engagez avec des chatbots d’IA, voici quelques pratiques clés à suivre :

- Familiarisez-vous avec les politiques de confidentialité des chatbots pour comprendre les risques associés.

- Évitez de poser des questions susceptibles de révéler par inadvertance votre identité ou des informations personnelles.

- Faites preuve de prudence et abstenez-vous de partager vos informations médicales avec des robots d’IA.

- Soyez attentif aux vulnérabilités potentielles de vos données lorsque vous utilisez des chatbots d’IA sur des plateformes sociales telles que SnapChat.

Les chatbots d’IA sont merveilleux pour de nombreuses utilisations, mais ils présentent également de sérieux risques pour la vie privée. Protéger vos données personnelles lorsque vous utilisez ChatGPT, Copilot, Claude ou tout autre chatbot d’IA n’est pas particulièrement difficile non plus. Il suffit de prendre un moment pour réfléchir à ce qui se passerait si les informations que vous partagez étaient divulguées. Vous saurez alors ce dont vous devez parler et ce que vous devez garder pour vous.

Qu’est-ce qu’il ne faut pas mettre dans ChatGPT ?

Votre nom, votre adresse, votre numéro de téléphone, même le nom de votre premier animal de compagnie.tous ces éléments sont à proscrire dans ChatGPT. Tout ce qui est personnel peut être exploité pour usurper votre identité, ce que les fraudeurs peuvent utiliser pour infiltrer des comptes privés ou réaliser des escroqueries par usurpation d’identité – ce qui n’est pas une bonne nouvelle pour vous.

Parmi les éléments suivants, lesquels ne devez-vous jamais partager sur les plateformes publiques d’IA ?

Attention aux informations personnelles Les enfants devraient éviter de partager des informations sensibles telles que leur nom complet, leur adresse, leur numéro de téléphone ou des informations financières, à moins qu’ils ne fassent confiance à la plateforme et qu’ils sachent comment elle traite les données personnelles.

Est-il prudent de partager des informations personnelles avec un chatbot ?

Si des cartes de crédit ou d’autres données personnelles étaient partagées et stockées dans des chats automatisés, des pirates informatiques pourraient les voler et les manipuler. Quel que soit le chatbot que vous utilisez, il est essentiel d’être vigilant et de protéger vos informations personnelles.

Est-il sûr de partager des idées avec ChatGPT ?

ChatGPT lui-même déclare : « Il est essentiel d’être prudent et d’éviter de partager des informations sensibles, personnellement identifiables ou confidentielles lors de l’interaction avec des modèles d’IA tels que ChatGPT.