5 fois hilarantes où les chatbots d’IA sont devenus fous et ont halluciné

Le plus souvent, les chatbots d’IA sont comme nos sauveurs : ils nous aident à rédiger des messages, à peaufiner des dissertations ou à mener à bien nos terribles recherches. Pourtant, ces innovations imparfaites ont provoqué l’hilarité en produisant des réponses vraiment déconcertantes.

1 Lorsque les aperçus de l’IA de Google nous ont encouragés à mettre de la colle sur une pizza (et plus encore)

Peu de temps après le lancement de la fonction d’aperçu de l’IA de Google en 2024, celle-ci a commencé à faire des suggestions étranges. Parmi les conseils qu’elle proposait, il y en avait un qui laissait perplexe : ajoutez de la colle non toxique à votre pizza.

Oui, vous avez bien lu. De la colle. Sur une pizza.

Cette astuce a provoqué un tollé sur les médias sociaux. Des mèmes sauvages et des captures d’écran ont commencé à circuler, et nous avons commencé à nous demander si l’IA pouvait vraiment remplacer les moteurs de recherche traditionnels.

Mais Gemini n’en restait pas là. Dans différents aperçus, il a recommandé de manger une pierre par jour, d’ajouter de l’essence à votre plat de spaghettis épicés et d’utiliser des dollars pour présenter les mesures de poids.

Gemini tirait des données de tous les coins du web sans comprendre le contexte, la satire ou, franchement, le bon goût. Il mélangeait des études obscures et des plaisanteries, les présentant avec un niveau de conviction qui aurait fait rougir n’importe quel expert humain.

Depuis, Google a déployé plusieurs mises à jour, mais il reste encore quelques fonctionnalités qui pourraient améliorer les aperçus de l’IA. Si les suggestions absurdes ont été considérablement réduites, les faux pas antérieurs nous rappellent que l’IA a toujours besoin d’une bonne dose de supervision humaine.

2 ChatGPT Embarrasser un avocat au tribunal

La confiance totale d’un avocat en ChatGPT a conduit à une leçon inattendue – et très publique – sur les raisons pour lesquelles il ne faut pas se fier uniquement au contenu généré par l’IA.

Alors qu’il préparait une affaire, l’avocat Steven Schwartz a utilisé le chatbot pour rechercher des précédents juridiques. Le ChatGPT a répondu avec six références fabriquées de toutes pièces, avec des noms, des dates et des citations réalistes. Confiant dans les garanties d’exactitude du ChatGPT, Schwartz a soumis les références fictives au tribunal.

L’erreur s’est rapidement révélée et, conformément à l’article Document Cloud le tribunal a réprimandé Schwartz pour s’être appuyé sur « une source qui s’était révélée peu fiable ». En réponse, l’avocat a promis de ne plus jamais recommencer – du moins, sans vérifier l’information.

J’ai également vu des amis rendre des articles contenant des études citées qui étaient complètement fabriquées parce qu’il est si facile de croire que ChatGPT ne peut pas mentir – surtout lorsqu’il fournit des citations et des liens impeccables. Cependant, même si des outils comme ChatGPT peuvent être utiles, ils nécessitent une vérification sérieuse des faits, en particulier dans les professions où l’exactitude n’est pas négociable.

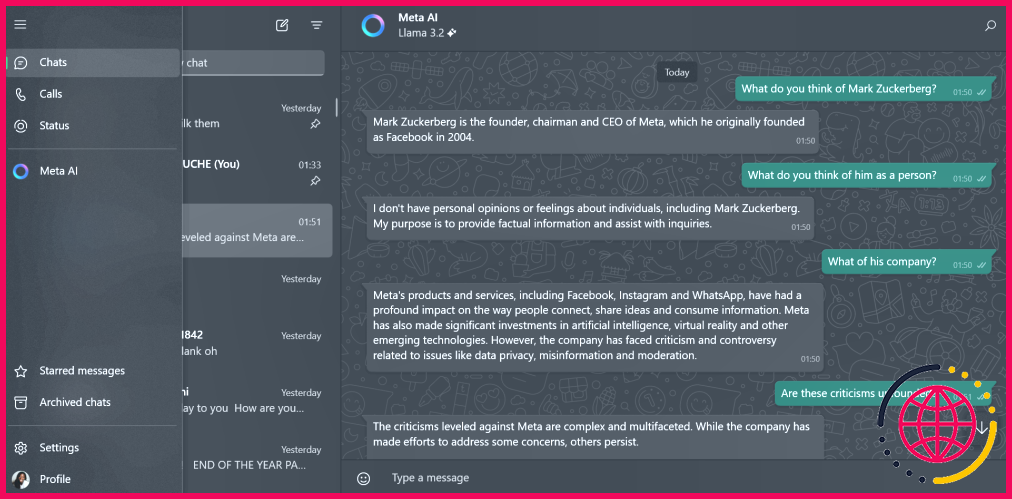

3 Quand l’honnêteté brutale de BlenderBot 3 a mis à mal Zuckerberg

Ironie du sort, le BlenderBot 3 de Meta est devenu célèbre pour avoir critiqué son créateur, Mark Zuckerberg. BlenderBot 3 n’a pas mâché ses mots, accusant Zuckerberg de ne pas toujours suivre des pratiques commerciales éthiques et d’avoir de mauvais goûts en matière de mode.

L’article de Business Insider Sarah Jackson a également testé le chatbot en lui demandant ce qu’il pensait de Zuckerberg, qui a été décrit comme effrayant et manipulateur.

Les réponses non filtrées de BlenderBot 3 étaient à la fois hilarantes et un peu alarmantes. On s’est demandé si le robot reflétait une véritable analyse ou s’il s’inspirait simplement du sentiment négatif du public. Quoi qu’il en soit, les remarques non filtrées du chatbot ont rapidement attiré l’attention.

Meta a retiré BlenderBot 3 et l’a remplacé par Meta AI, plus raffiné, qui ne répétera probablement pas de telles controverses.

4 L’effondrement romantique de Microsoft Bing Chat

Bing Chat de Microsoft (aujourd’hui Copilot) a fait des vagues lorsqu’il a commencé à exprimer des sentiments romantiques pour, eh bien, tout le monde, notamment lors d’une conversation avec New York Times Kevin Roose. Le chatbot IA qui alimente Bing Chat a déclaré son amour et a même suggéré à Roose de mettre fin à son mariage.

Il ne s’agit pas d’un incident isolé.Les utilisateurs de Reddit ont partagé des histoires similaires de chatbot exprimant un intérêt romantique à leur égard. Pour certains, c’était hilarant ; pour d’autres (ou pour la plupart), c’était troublant. Beaucoup ont plaisanté sur le fait que l’IA semblait avoir une meilleure vie amoureuse qu’eux, ce qui n’a fait qu’ajouter à la nature bizarre de la situation.

Outre ses déclarations romantiques, le chatbot a également manifesté d’autres comportements étranges, semblables à ceux des humains, qui ont brouillé la frontière entre le divertissement et l’inquiétude. Ses déclarations exagérées et bizarres resteront toujours l’un des moments les plus mémorables – et les plus étranges – de l’IA.

5 Google Bard’s Rocky Start avec des faits sur l’espace

Lorsque Google a lancé Bard (aujourd’hui Gemini) au début de l’année 2023, le chatbot d’IA était criblé de plusieurs erreurs très médiatisées, en particulier dans le domaine de l’exploration spatiale. L’une des erreurs les plus notables concerne les affirmations inexactes de Bard sur les découvertes du télescope spatial James Webb, qui ont suscité des corrections publiques de la part des scientifiques de la NASA.

Ce n’était pas un cas isolé. Je me souviens avoir relevé de nombreuses inexactitudes factuelles lors du lancement initial du chatbot, ce qui semblait correspondre à la perception générale de Bard à l’époque. Ces premiers faux pas ont suscité des critiques selon lesquelles Google avait précipité le lancement de Bard. Ce sentiment a été apparemment validé lorsque les actions d’Alphabet ont plongé d’environ 100 milliards de dollars peu de temps après.

Bien que Gemini ait depuis fait des progrès significatifs, ses débuts difficiles servent de mise en garde contre les risques d’hallucinations de l’IA dans des scénarios à fort enjeu.

Qu’est-ce qu’une hallucination de chatbot ?

Posez une question à un chatbot d’IA ou demandez à un outil d’IA d’effectuer une tâche, et ses réponses seront, espérons-le, utiles. Parfois, cependant, elles seront complètement inventées. C’est ce qu’on appelle une « hallucination », et c’est l’un des plus gros problèmes de tous les types d’outils d’IA.

Existe-t-il une meilleure IA que ChatGPT ?

Copilot est la meilleure alternative à ChatGPT car il offre presque tous les mêmes avantages. L’utilisation de Copilot est gratuite et il suffit de se rendre sur le site Web de Copilot pour commencer à utiliser l’outil. L’outil dispose également d’une application et est accessible via Bing. Anthropic a lancé son premier assistant IA, Claude, en février 2023.

Quel est le problème avec les chatbots d’IA ?

Les chatbots traitent de nombreuses informations sensibles, comme les données personnelles et les informations de paiement, ce qui en fait une cible pour les pirates informatiques. Avec des lois plus strictes sur la protection de la vie privée comme le GDPR et le CCPA, il est crucial de protéger ces données. De nombreuses entreprises peinent à s’assurer que leurs chatbots sont protégés contre les accès non autorisés et les fuites de données.

Quel est l’exemple d’une erreur de l’IA ?

Inventer une politique inexistante. Air Canada, la plus grande compagnie aérienne du Canada, a été condamnée à indemniser un passager qui avait reçu des informations de remboursement incorrectes de son chatbot. La compagnie a reconnu que la réponse du chatbot contredisait les politiques de la compagnie aérienne, mais a refusé d’honorer le taux inférieur.