Les 6 meilleurs modèles pré-entraînés pour le travail et les affaires

La barrière à la formation d’une IA efficace et fiable a considérablement diminué grâce à la diffusion publique de nombreux modèles pré-entraînés. Grâce à ces modèles pré-entraînés, les chercheurs indépendants et les petites entreprises peuvent rationaliser les processus, améliorer la productivité et obtenir des informations précieuses grâce à l’utilisation de l’IA.

Il existe désormais de nombreux modèles pré-entraînés que vous pouvez utiliser et affiner. En fonction de votre problème spécifique, vous souhaiterez peut-être utiliser un modèle plutôt qu’un autre. Comment savoir quel modèle pré-entraîné utiliser ?

Pour vous aider à prendre votre décision, voici quelques-uns des modèles préformés les plus populaires que vous pouvez utiliser pour stimuler votre travail et la productivité de votre entreprise.

1. BERT (Bidirectional Encoder Representations from Transformers)

BERT est un transformateur de codeur qui a révolutionné le traitement du langage naturel (NLP) grâce à son mécanisme d’auto-attention. Contrairement aux réseaux neuronaux récurrents traditionnels (RNN) qui traitent les phrases un mot après l’autre, le mécanisme d’auto-attention de BERT permet au modèle d’évaluer l’importance des mots dans une séquence en calculant des scores d’attention entre eux.

Les modèles BERT ont la capacité de comprendre le contexte profond d’une séquence de mots. Les modèles BERT sont donc idéaux pour les applications qui requièrent une intégration contextuelle puissante et de bonnes performances dans diverses tâches de NLP telles que la classification de textes, la reconnaissance d’entités nommées et la réponse à des questions.

Les modèles BERT sont généralement volumineux et leur apprentissage nécessite un matériel coûteux. Ainsi, bien qu’ils soient considérés comme les meilleurs pour de nombreuses applications de TAL, l’inconvénient de la formation des modèles BERT est que le processus est souvent coûteux et prend du temps.

2. DistilBERT (BERT distillé) :

Vous cherchez à affiner un modèle BERT mais vous n’avez ni l’argent ni le temps nécessaires ? DistilBERT est une version distillée de BERT qui conserve environ 95 % de ses performances tout en n’utilisant que la moitié du nombre de paramètres !

DistilBERT utilise une approche de formation enseignant-étudiant où BERT est l’enseignant et DistilBERT l’étudiant. Le processus de formation implique la distillation des connaissances de l’enseignant à l’étudiant en formant DistilBERT à imiter le comportement et les probabilités de sortie de BERT.

En raison du processus de distillation, DistilBERT n’a pas d’encastrements de type jeton, a des têtes d’attention réduites et moins de couches d’anticipation. Cela permet de réduire considérablement la taille du modèle, mais sacrifie certaines performances.

Tout comme l’ORET, DistilBERT est mieux adapté à la classification de textes, à la reconnaissance d’entités nommées, à la similarité de textes et à la paraphrase, à la réponse à des questions et à l’analyse de sentiments. L’utilisation de DistilBERT ne vous permettra peut-être pas d’atteindre le même niveau de précision qu’avec BERT. Cependant, l’utilisation de DistilBERT vous permet d’affiner votre modèle beaucoup plus rapidement tout en dépensant moins en formation.

3. GPT (Generative Pre-trained Transformer)

Vous avez besoin d’un outil qui vous aide à générer du contenu, à donner des suggestions ou à résumer un texte ? GPT est le modèle pré-entraîné d’OpenAI qui produit des textes cohérents et pertinents d’un point de vue contextuel.

Contrairement à BERT, qui est conçu selon l’architecture du transformateur d’encodage, GPT est conçu comme un transformateur de décodage. Cela permet à GPT d’être excellent dans la prédiction des mots suivants sur la base du contexte de la séquence précédente. Entraîné sur de grandes quantités de textes sur l’internet, le GPT a appris des modèles et des relations entre les mots et les phrases. Cela lui permet de savoir quels sont les mots les plus appropriés à utiliser dans un certain scénario. Comme il s’agit d’un modèle pré-entraîné populaire, il existe des outils avancés tels qu’AutoGPT que vous pouvez utiliser dans le cadre de votre travail et de votre entreprise.

Bien qu’il imite parfaitement le langage humain, le GPT ne repose sur aucun fait autre que l’ensemble des données utilisées pour former le modèle. Comme il se contente de générer des mots qui ont un sens en fonction du contexte des mots précédents, il peut parfois fournir des réponses incorrectes, inventées ou non factuelles. Un autre problème que vous pourriez rencontrer lors du réglage fin de GPT est qu’OpenAI n’autorise l’accès qu’au moyen d’une API. Ainsi, que vous souhaitiez affiner GPT ou simplement continuer à entraîner ChatGPT avec vos données personnalisées, vous devrez payer une clé API.

4. T5 (Transformateur de transfert de texte à texte)

T5 est un modèle NLP très polyvalent qui combine les architectures d’encodage et de décodage pour traiter un large éventail de tâches NLP. T5 peut être utilisé pour la classification, le résumé, la traduction, la réponse aux questions et l’analyse des sentiments.

Le T5 ayant des modèles de petite, base et grande taille, vous pouvez obtenir un modèle de transformateur codeur-décodeur qui correspond mieux à vos besoins en termes de performance, de précision, de temps d’apprentissage et de coût de réglage fin. Les modèles T5 sont les mieux adaptés lorsque vous ne pouvez mettre en œuvre qu’un seul modèle pour vos applications NLP. Toutefois, si vous devez obtenir les meilleures performances en matière de NLP, vous pouvez utiliser un modèle distinct pour les tâches d’encodage et de décodage.

5. ResNet (Réseau neuronal résiduel)

Vous recherchez un modèle capable de réaliser des tâches de vision par ordinateur ? ResNet est un modèle d’apprentissage profond conçu selon l’architecture de réseau neuronal convolutif (CNN) qui est utile pour les tâches de vision par ordinateur telles que la reconnaissance d’images, la détection d’objets et la segmentation sémantique. ResNet étant un modèle pré-entraîné populaire, vous pouvez trouver des modèles affinés, puis utiliser l’apprentissage par transfert pour accélérer l’entraînement du modèle.

ResNet fonctionne en commençant par comprendre la différence entre l’entrée et la sortie, également connue sous le nom de « résidus ». Une fois les résidus identifiés, ResNet s’attache à déterminer ce qui est le plus probable entre ces entrées et ces sorties. En entraînant ResNet sur un grand ensemble de données, le modèle a appris des modèles et des caractéristiques complexes et peut comprendre à quoi ressemblent normalement les objets, ce qui fait de ResNet un excellent outil pour remplir les zones intermédiaires entre l’entrée et la sortie d’une image.

Étant donné que ResNet ne développe sa compréhension que sur la base de l’ensemble de données fourni, le problème de l’ajustement excessif peut se poser. Cela signifie que si l’ensemble de données pour un sujet spécifique est insuffisant, ResNet peut identifier un sujet de manière erronée. Par conséquent, si vous deviez utiliser un modèle ResNet, vous devriez affiner le modèle à l’aide d’un ensemble de données substantiel afin de garantir sa fiabilité.

6. VGGNet (Visual Geometry Group Network)

VGGNet est un autre modèle populaire de vision par ordinateur, plus facile à comprendre et à mettre en œuvre que ResNet. Bien que moins puissant, VGGNet utilise une approche plus directe que ResNet, en utilisant une architecture uniforme qui décompose les images en petits morceaux et apprend ensuite progressivement ses caractéristiques.

Grâce à cette méthode plus simple d’analyse des images, VGGNet est plus facile à comprendre, à mettre en œuvre et à modifier, même pour les chercheurs ou les praticiens de l’apprentissage profond relativement novices. Vous pouvez également vouloir utiliser VGGNet plutôt que ResNet si vous disposez d’un ensemble de données et de ressources limitées et que vous souhaitez affiner le modèle pour qu’il soit plus efficace dans un domaine spécifique.

De nombreux autres modèles pré-entraînés sont disponibles

Nous espérons que vous avez maintenant une meilleure idée des modèles pré-entraînés que vous pouvez utiliser pour votre projet. Les modèles présentés sont parmi les plus populaires dans leurs domaines respectifs. Gardez à l’esprit qu’il existe de nombreux autres modèles pré-entraînés disponibles publiquement dans les bibliothèques d’apprentissage profond, telles que TensorFlow Hub et PyTorch.

Par ailleurs, vous n’êtes pas obligé de vous en tenir à un seul modèle pré-entraîné. Tant que vous disposez des ressources et du temps nécessaires, vous pouvez toujours mettre en œuvre plusieurs modèles pré-entraînés qui profitent à votre application.

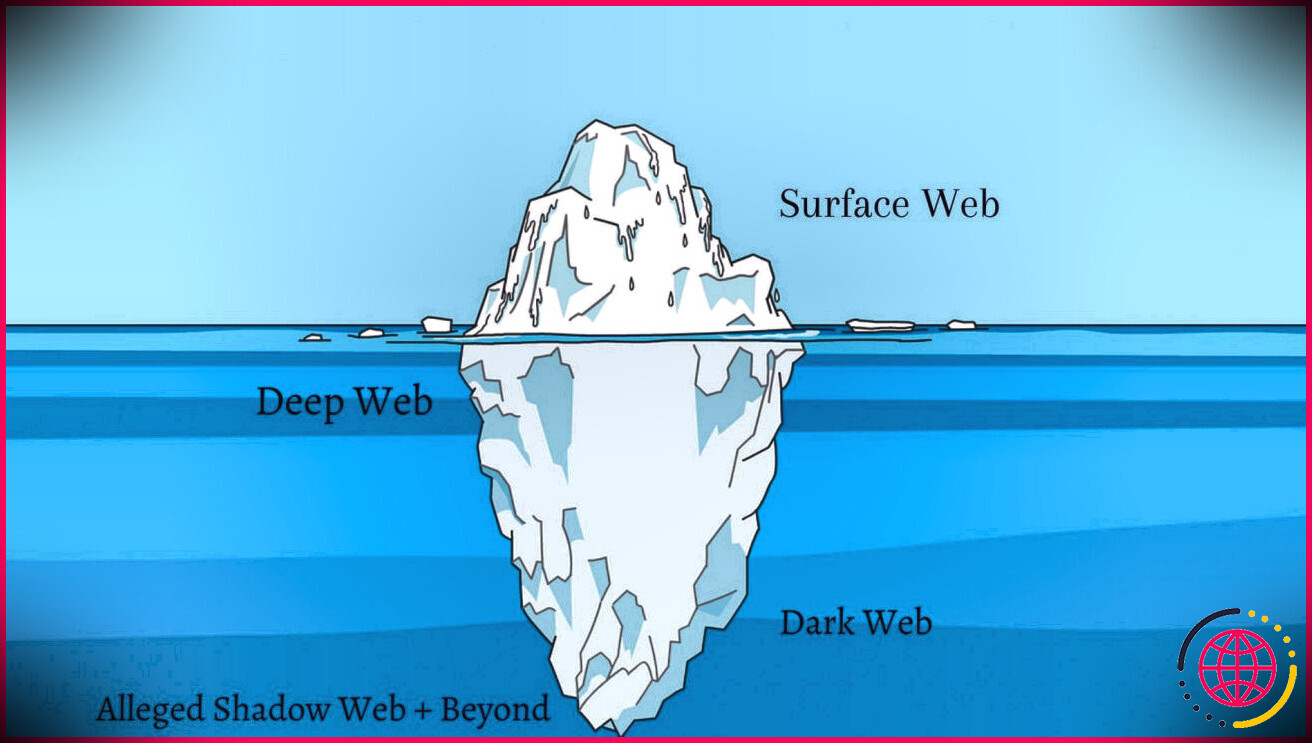

Quels sont les modèles pré-entraînés ?

Un modèle pré-entraîné est un modèle ou un réseau sauvegardé créé par quelqu’un d’autre et entraîné sur un grand ensemble de données pour résoudre un problème similaire. Les équipes d’IA peuvent utiliser un modèle pré-entraîné comme point de départ, au lieu de construire un modèle à partir de zéro.

Quels sont les types de modèles NLP pré-entraînés ?

Parmi les modèles pré-entraînés les plus populaires pour le NLP figurent BERT, GPT-2, ELMo et RoBERTa. Ces modèles sont entraînés sur de grands ensembles de données textuelles et peuvent être affinés pour des tâches spécifiques.

Qu’est-ce qu’un modèle d’IA pré-entraîné ?

Un modèle d’IA pré-entraîné est un modèle d’apprentissage profond – une expression d’un algorithme neuronal semblable à un cerveau qui trouve des modèles ou fait des prédictions basées sur des données – qui est entraîné sur de grands ensembles de données pour accomplir une tâche spécifique. Il peut être utilisé tel quel ou affiné pour répondre aux besoins spécifiques d’une application.

Qu’est-ce qu’un CNN pré-entraîné ?

Dernière mise à jour le 1er juin 2023. Les réseaux neuronaux convolutionnels (CNN) pré-entraînés sont des modèles qui ont été entraînés sur de grands ensembles de données, tels qu’ImageNet, et qui peuvent être réutilisés pour diverses tâches, telles que la classification d’images, la détection d’objets ou la reconnaissance de visages.