Quand l’hypothèse de linéarité est-elle violée ?

L’hypothèse de linéarité est un principe fondamental du raisonnement scientifique qui stipule que les propriétés d’un système (par exemple, la position et la vitesse d’une particule) sont invariantes lorsque le temps change. En d’autres termes, la loi de conservation de la quantité de mouvement doit être respectée dans un système physique. Si cette hypothèse n’est pas respectée, les prédictions sur le comportement du système peuvent ne pas être fiables.

Une situation où l’hypothèse de linéarité peut être violée est lorsqu’un système est soumis à une force externe. Si la force est trop forte, elle peut perturber l’équilibre du système, entraînant une modification de ses propriétés (par exemple, la quantité de mouvement et la position) avec le temps. Ce type de changement est souvent appelé comportement chaotique parce qu’il n’a aucun schéma perceptible. Le degré auquel l’hypothèse de linéarité est violée peut dépendre de plusieurs facteurs, tels que l’ampleur et la direction de la force externe, la nature du système physique étudié et la qualité de son étude.

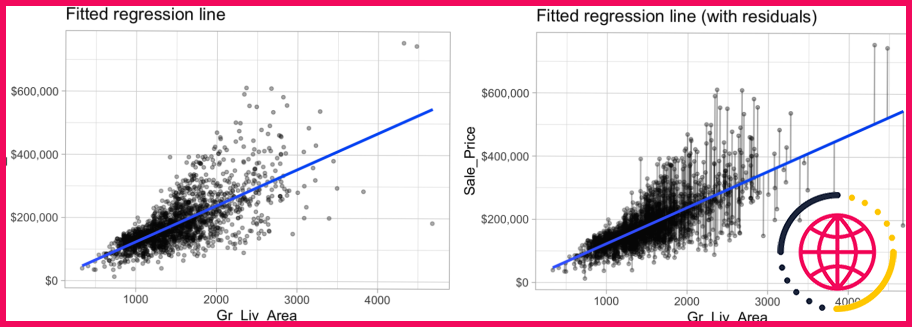

L’hypothèse de linéarité est violée – il y a une courbe. L’hypothèse d’égale variance est également violée, les résidus s’étalent en éventail de façon » triangulaire « . Dans l’image ci-dessus, les deux hypothèses de linéarité et de variance égale sont violées.

Que se passe-t-il si les hypothèses de la régression linéaire sont violées ?

Si l’une de ces hypothèses est violée (c’est-à-dire s’il existe des relations non linéaires entre les variables dépendantes et indépendantes ou si les erreurs présentent une corrélation, une hétéroscédasticité ou une non-normalité), alors les prévisions, les intervalles de confiance et les connaissances scientifiques produites par un modèle de régression peuvent être (au mieux) .

Comment savoir si une hypothèse de régression est violée ?

Les violations potentielles de l’hypothèse comprennent :

- Variables indépendantes implicites : X variables manquantes dans le modèle.

- Manque d’indépendance de Y : manque d’indépendance de la variable Y.

- Valeurs aberrantes : non normalité apparente de quelques points de données.

- Nonnormalité : nonnormalité de la variable Y.

- Variance de Y non constante.

Quelles hypothèses sont violées ?

situation dans laquelle les hypothèses théoriques associées à une procédure statistique ou expérimentale particulière ne sont pas respectées.

Que se passe-t-il lorsque les hypothèses de la régression linéaire ne sont pas respectées ?

Par exemple, lorsque les hypothèses statistiques de la régression ne peuvent pas être satisfaites (remplies par le chercheur) choisissez une méthode différente. La régression nécessite que sa variable dépendante soit au moins des données d’intervalle ou de rapport.

Que se passe-t-il si les hypothèses des MCO sont violées ?

La violation de l’hypothèse deux conduit à une interception biaisée. La violation de l’hypothèse trois conduit au problème des variances inégales donc bien que les estimations des coefficients seront toujours non biaisées mais les erreurs standard et les inférences basées sur elle peuvent donner des résultats trompeurs.

Que faire si les hypothèses de régression sont violées ?

Si les diagnostics de régression ont permis d’éliminer les observations aberrantes et influentes, mais que les tracés des résidus et des résidus partiels montrent toujours que les hypothèses du modèle sont violées, il est nécessaire de procéder à d’autres ajustements, soit au modèle (en incluant ou en excluant des prédicteurs), soit en transformant les .

Quelles sont les hypothèses des MCO ?

Hypothèse 3 des MCO : la moyenne conditionnelle doit être égale à zéro. La valeur attendue de la moyenne des termes d’erreur de la régression MCO devrait être nulle étant donné les valeurs des variables indépendantes. L’hypothèse MCO d’absence de multi-collinéarité dit qu’il ne devrait pas y avoir de relation linéaire entre les variables indépendantes.

Que se passe-t-il quand on viole l’homoscédasticité ?

L’hétéroscédasticité (la violation de l’homoscédasticité) est présente lorsque la taille du terme d’erreur diffère selon les valeurs d’une variable indépendante. L’impact de la violation de l’hypothèse d’homoscédasticité est une question de degré, augmentant à mesure que l’hétéroscédasticité augmente.

Comment corriger la violation de la normalité ?

Lorsqu’on constate que la distribution des résidus s’écarte de la normalité, les solutions possibles consistent à transformer les données, à éliminer les valeurs aberrantes ou à effectuer une analyse alternative qui ne nécessite pas la normalité (par exemple, une régression non paramétrique).

Quelles sont les hypothèses les plus importantes dans la régression linéaire ?

Il y a quatre hypothèses associées à un modèle de régression linéaire : Linéarité : La relation entre X et la moyenne de Y est linéaire. Homoscédasticité : La variance du résidu est la même pour toute valeur de X. Indépendance : Les observations sont indépendantes les unes des autres.

Comment vérifier l’hypothèse de linéarité dans une régression multiple ?

La première hypothèse de la régression linéaire multiple est qu’il existe une relation linéaire entre la variable dépendante et chacune des variables indépendantes. La meilleure façon de vérifier les relations linéaires est de créer des nuages de points puis d’inspecter visuellement les nuages de points pour vérifier la linéarité.

Lesquelles des situations suivantes peuvent être des conséquences de la violation d’une ou plusieurs des hypothèses du modèle de régression linéaire classique ?

Si une ou plusieurs des hypothèses sont violées, soit les coefficients pourraient être erronés, soit leurs erreurs standard pourraient être erronées, et dans les deux cas, tout test d’hypothèse utilisé pour étudier la force des relations entre les variables explicatives et expliquées pourrait être invalide.

Pourquoi l’homoscédasticité est-elle violée ?

Généralement, les violations de l’homoscédasticité se produisent lorsqu’une ou plusieurs des variables étudiées ne sont pas normalement distribuées. Parfois, l’hétéroscédasticité peut provenir de quelques valeurs discordantes (points de données atypiques) qui peuvent refléter des observations extrêmes réelles ou une erreur d’enregistrement ou de mesure.

Pourquoi l’homoscédasticité est-elle mauvaise ?

Il y a deux grandes raisons pour lesquelles vous voulez l’homoscédasticité : Bien que l’hétéroscédasticité ne provoque pas de biais dans les estimations des coefficients, elle les rend moins précises. Cet effet se produit parce que l’hétéroscédasticité augmente la variance des estimations des coefficients, mais la procédure des MCO ne détecte pas cette augmentation.

Quelles sont les conséquences de l’estimation de votre modèle alors que l’hypothèse d’homoscédasticité est violée ?

Bien que l’estimateur des paramètres de régression dans la régression MCO soit sans biais lorsque l’hypothèse d’homoscédasticité est violée, l’estimateur de la matrice de covariance des estimations des paramètres peut être biaisé et incohérent en cas d’hétéroscédasticité, ce qui peut produire des tests de signification et des intervalles de confiance .

Quelles sont les hypothèses de la régression logistique ?

Les hypothèses de base qui doivent être respectées pour la régression logistique comprennent l’indépendance des erreurs, la linéarité du logit pour les variables continues, l’absence de multicollinéarité et l’absence de valeurs aberrantes fortement influentes.

Pourquoi les MCO sont-ils sans biais ?

En statistique, les moindres carrés ordinaires (MCO) sont un type de méthode des moindres carrés linéaires pour estimer les paramètres inconnus dans un modèle de régression linéaire. Dans ces conditions, la méthode des MCO fournit une estimation sans biais moyen à variance minimale lorsque les erreurs ont des variances finies.

Quelle est l’hypothèse d’homoscédasticité ?

L’hypothèse d’égalité des variances (c’est-à-dire l’hypothèse d’homoscédasticité) suppose que différents échantillons ont la même variance, même s’ils proviennent de populations différentes. Cette hypothèse se retrouve dans de nombreux tests statistiques, notamment l’analyse de la variance (ANOVA) et le test T de Student.

La régression linéaire est-elle la même que les MCO ?

La régression par moindres carrés ordinaires (MCO) est plus communément appelée régression linéaire (simple ou multiple selon le nombre de variables explicatives). La méthode des MCO correspond à la minimisation de la somme des différences carrées entre les valeurs observées et prédites.

Comment tester la linéarité ?

L’hypothèse de linéarité peut être mieux testée avec des diagrammes de dispersion, les deux exemples suivants décrivent deux cas, où aucune et peu de linéarité est présente. Deuxièmement, l’analyse de régression linéaire exige que toutes les variables soient normales à plusieurs variables. Cette hypothèse peut être mieux vérifiée avec un histogramme ou un Q-Q-Plot.

Quelles sont les hypothèses des régressions multiples ?

Normalité multivariée-La régression multiple suppose que les résidus sont normalement distribués. Pas de multicolinéarité-La régression multiple suppose que les variables indépendantes ne sont pas fortement corrélées entre elles. Cette hypothèse est testée à l’aide des valeurs du facteur d’inflation de la variance (VIF).

Comment savoir si une distribution est normale ?

L’histogramme et le diagramme de probabilité normale sont utilisés pour vérifier s’il est raisonnable ou non de supposer que les erreurs aléatoires inhérentes au processus ont été tirées d’une distribution normale. Au contraire, si les erreurs aléatoires sont normalement distribuées, les points tracés seront proches de la ligne droite.

Qu’est-ce que l’hypothèse de multicolinéarité ?

La multicollinéarité est une condition dans laquelle les variables indépendantes sont fortement corrélées (r=0,8 ou plus) de sorte que les effets des indépendants sur la variable de résultat ne peuvent être séparés. En d’autres termes, l’une des variables prédictives peut être presque parfaitement prédite par l’une des autres variables prédictives.

Quelles sont les quatre hypothèses de la régression ?

Les quatre hypothèses de la régression linéaire.

- Relation linéaire : Il existe une relation linéaire entre la variable indépendante, x, et la variable dépendante, y.

- Indépendance : Les résidus sont indépendants.

- Homoscédasticité : Les résidus ont une variance constante à chaque niveau de x.