Introduction à LangChain LLM : Guide du débutant

Avec l’introduction des grands modèles de langage (LLM), le traitement du langage naturel est devenu le sujet de discussion de l’internet. De nouvelles applications sont développées quotidiennement grâce à des LLM tels que ChatGPT et LangChain.

LangChain est un framework Python open-source permettant aux développeurs de développer des applications alimentées par de grands modèles de langage. Ses applications sont les chatbots, les résumés, les questions et réponses génératives, et bien d’autres encore.

Cet article est une introduction à LangChain LLM. Il couvrira les concepts de base, comment il se compare à d’autres modèles de langage, et comment commencer à l’utiliser.

Comprendre le LangChain LLM

Avant d’expliquer le fonctionnement de LangChain, il faut d’abord comprendre comment fonctionnent les grands modèles de langage. Un grand modèle de langage est un type d’intelligence artificielle (IA) qui utilise l’apprentissage profond pour former les modèles d’apprentissage automatique sur des données volumineuses composées de données textuelles, numériques et de code.

La grande quantité de données permet au modèle d’apprendre les modèles existants et les relations entre les mots, les chiffres et les symboles. Cette caractéristique permet au modèle d’effectuer une série de tâches, telles que :

- La génération de textes, la traduction de langues, la rédaction de contenus créatifs, techniques et académiques, et la réponse à des questions précises et pertinentes.

- Détection d’objets dans les images.

- Résumé de livres, d’articles et de documents de recherche.

La limitation la plus importante des LLM est que les modèles sont très généraux. Cette caractéristique signifie que malgré leur capacité à effectuer plusieurs tâches efficacement, ils peuvent parfois fournir des réponses générales à des questions ou des invites nécessitant une expertise et une connaissance approfondie du domaine au lieu de réponses spécifiques.

Développé par Harrison Chase à la fin de l’année 2022, le cadre LangChain offre une approche innovante des LLM. Le processus commence par le prétraitement des textes de l’ensemble de données en les divisant en parties plus petites ou en résumés. Les résumés sont ensuite intégrés dans un espace vectoriel. Le modèle reçoit une question, recherche les résumés et fournit la réponse appropriée.

La méthode de prétraitement de LangChain est une caractéristique essentielle qui est inévitable à mesure que les LLM deviennent plus puissants et plus gourmands en données. Cette méthode est principalement utilisée dans les cas de recherche de code et de recherche sémantique car elle permet une collecte et une interaction en temps réel avec les LLM.

LangChain LLM par rapport à d’autres modèles linguistiques

L’aperçu comparatif suivant vise à mettre en évidence les caractéristiques et capacités uniques qui distinguent LangChain LLM des autres modèles de langage existants sur le marché :

- Mémoire: Plusieurs LLM ont une mémoire courte, ce qui entraîne généralement une perte de contexte si les invites dépassent la limite de mémoire. LangChain, cependant, fournit les invites et les réponses précédentes, ce qui résout le problème des limites de mémoire. L’historique des messages permet à l’utilisateur de répéter les messages précédents au LLM pour récapituler le contexte antérieur.

- Changement de LLM: Par rapport à d’autres LLM qui verrouillent votre logiciel avec l’API d’un modèle unique, LangChain fournit une abstraction qui simplifie le changement de LLM ou l’intégration de plusieurs LLM dans votre application. Ceci est utile lorsque vous souhaitez mettre à niveau les capacités de votre logiciel en utilisant un modèle compact, tel que le StableLM say de Stability AI à partir du GPT-3.5 d’OpenAI.

- Intégration: L’intégration de LangChain dans votre application est facile par rapport à d’autres LLM. Il fournit des flux de travail de pipeline par le biais de chaînes et agents ce qui vous permet d’intégrer rapidement LangChain dans votre application. En ce qui concerne les pipelines linéaires, les chaînes sont des objets qui relient essentiellement de nombreuses parties. Les agents sont plus avancés et vous permettent de choisir la manière dont les composants doivent interagir en utilisant la logique métier. Par exemple, vous pouvez utiliser une logique conditionnelle pour déterminer la prochaine action en fonction des résultats d’un LLM.

- Transmission des données: En raison de la nature textuelle des LLM, il est souvent difficile de transmettre des données au modèle. LangChain résout ce problème en utilisant index. Les index permettent à une application d’importer des données dans des formats variables et de les stocker de manière à pouvoir les transmettre ligne par ligne à un LLM.

- Réponses: LangChain fournit des outils d’analyse de sortie pour donner des réponses dans un format approprié, contrairement à d’autres LLM dont la réponse au modèle consiste en un texte général. Lorsque l’on utilise l’IA dans une application, il est préférable d’avoir une réponse structurée contre laquelle on peut programmer.

Premiers pas avec LangChain LLM

Vous allez maintenant apprendre à mettre en œuvre LangChain dans un scénario d’utilisation réel afin de comprendre son fonctionnement. Avant de commencer le développement, vous devez configurer l’environnement de développement.

Mise en place de l’environnement de développement

Tout d’abord, créez un environnement virtuel et installez les dépendances ci-dessous :

- OpenAI: Pour intégrer l’API GPT-3 dans votre application.

- LangChain: Pour intégrer LangChain dans votre application.

À l’aide de pip, exécutez la commande ci-dessous pour installer les dépendances :

La commande ci-dessus installe les paquets et crée un environnement virtuel.

Importer les dépendances installées

Tout d’abord, importez les classes nécessaires telles que LLMChain, OpenAI, Chaîne de conversation et PromptTemplate à partir des langchain .

Les classes LangChain décrivent et exécutent les chaînes de modèles linguistiques.

Accéder à la clé API de l’OpenAI

Ensuite, il faut obtenir la clé API d’OpenAI. Pour accéder à la clé API d’OpenAI, vous devez avoir un compte OpenAI. plateforme API OpenAI.

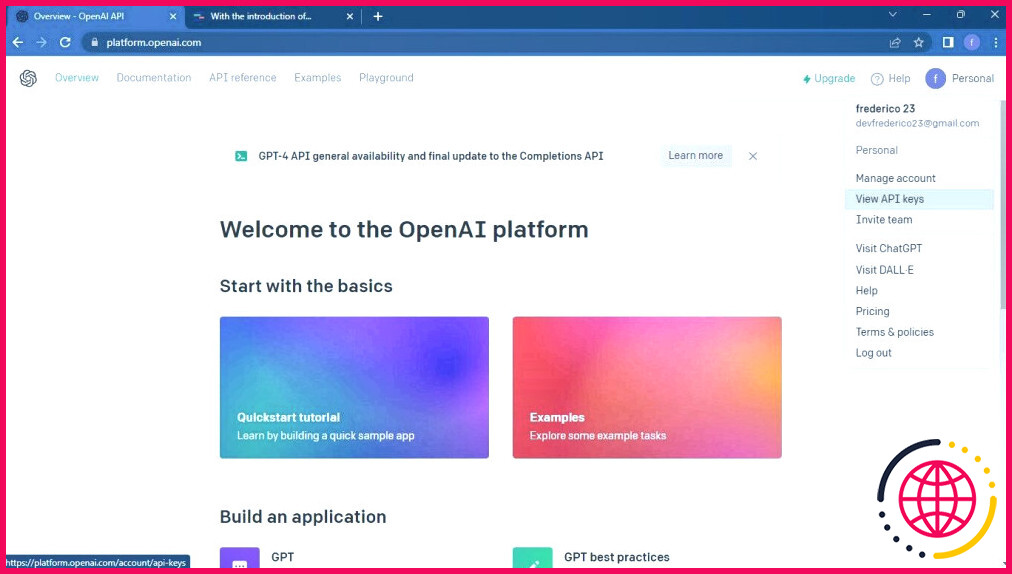

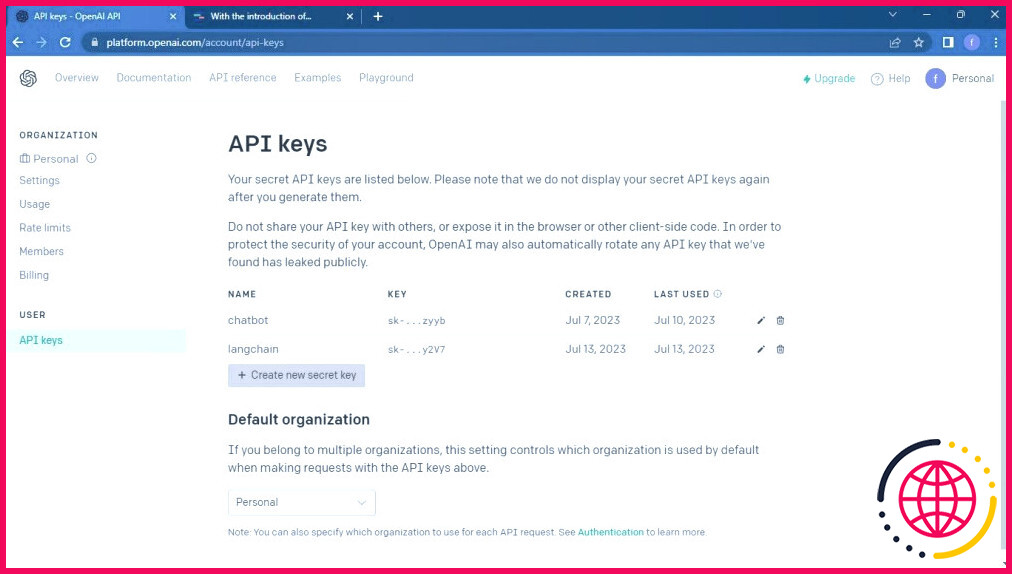

Sur le tableau de bord, cliquez sur l’icône Profil. Ensuite, cliquez sur l’icône Voir les clés API pour voir les clés API.

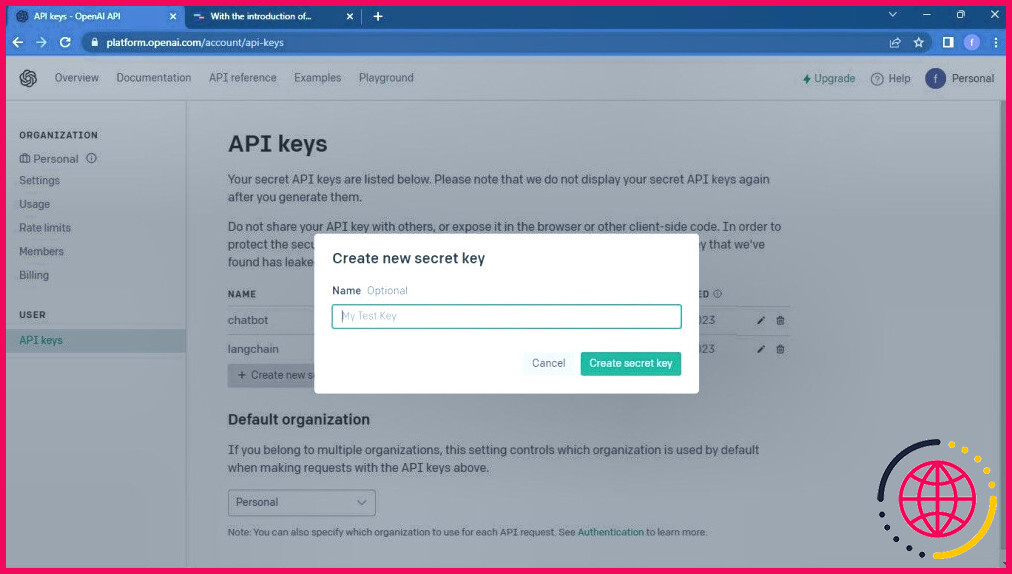

Cliquez ensuite sur le bouton Créer une nouvelle clé secrète pour obtenir une nouvelle clé API.

Saisissez le nom demandé pour la clé API.

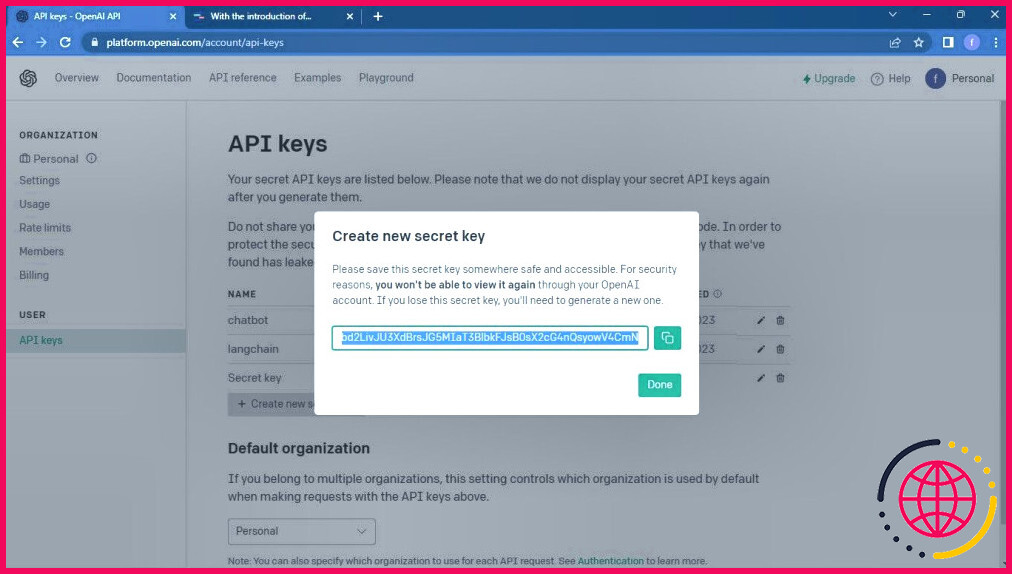

Vous recevrez un clé secrète invite.

Copiez et conservez la clé API dans un endroit sûr pour une utilisation ultérieure.

Développement d’une application à l’aide de LangChain LLM

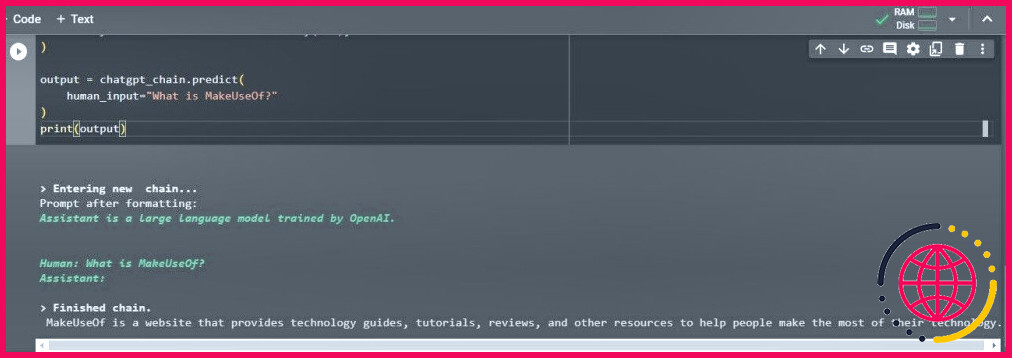

Vous allez maintenant développer une application de chat simple comme suit :

Ensuite, vous allez charger la chaîne ChatGPT à l’aide de la clé API que vous avez enregistrée précédemment.

Ce code charge la chaîne LLM avec la clé API OpenAI et le modèle d’invite. Les données de l’utilisateur sont ensuite fournies et la sortie est affichée.

Ci-dessus se trouve la sortie attendue.

L’influence croissante des LLM

La consommation de LLM augmente rapidement et modifie la façon dont les humains interagissent avec les machines à connaissance. Des structures telles que LangChain sont à l’avant-garde pour fournir aux développeurs un moyen simple et facile de servir les LLM aux applications. Les modèles d’IA générative tels que ChatGPT, Bard et Hugging Face ne sont pas en reste pour faire progresser les applications LLM.