4 façons de prévenir les hallucinations de l’IA

Bien que les modèles d’IA comme le ChatGPT d’OpenAI soient indubitablement utiles, ils ont tendance à fournir de temps à autre des informations factuellement incorrectes, un problème communément appelé « hallucinations ».

Les hallucinations se produisent parce que les modèles d’IA sont formés sur un ensemble de données relativement limité qui pourrait potentiellement être incorrect ou biaisé. Toutefois, il existe quelques mesures à prendre pour réduire les risques d’hallucinations.

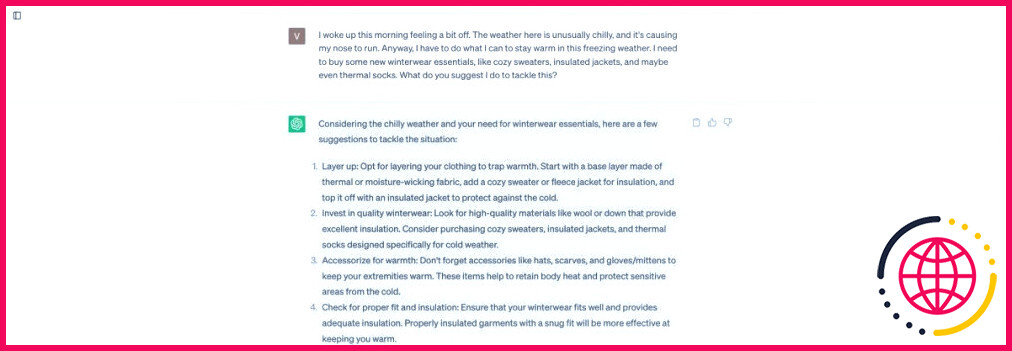

1. Utilisez un langage simple et direct

Lorsque vous utilisez des invites directes, vous réduisez la probabilité que le modèle d’IA interprète mal vos données. Veillez donc à ce que vos invites soient claires, directes et faciles à comprendre.

La rédaction d’une invite compliquée, comportant un certain nombre de détails superflus, a donné lieu à ChatGPT a mal interprété la question et a suggéré la meilleure façon d’acheter des vêtements d’hiver.

En revanche, l’utilisation d’une question plus simple et directe a permis d’obtenir des réponses plus précises et plus utiles.

Il est préférable de relire votre question pour vous assurer qu’elle se concentre sur l’objectif que vous souhaitez atteindre. Si vous constatez que votre entrée comprend des détails inutiles ou des phrases alambiquées, corrigez-les pour obtenir une réponse précise et empêcher l’outil d’IA d’halluciner.

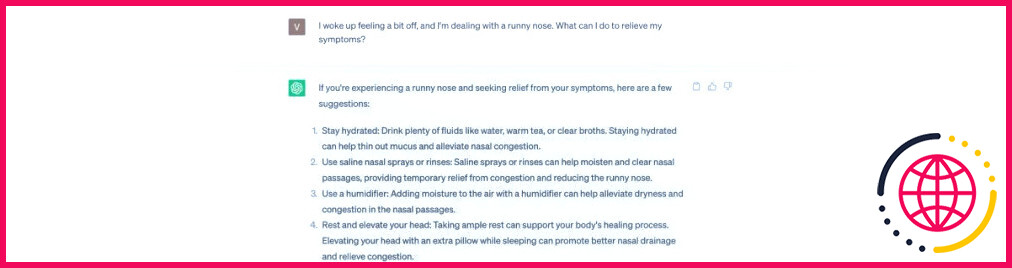

2. Incorporez le contexte dans vos messages-guides

Le fait de donner à l’outil d’IA un certain contexte dans votre invite peut l’aider à générer une réponse plus précise. Le contexte permet de réduire les possibilités potentielles et encourage la plateforme d’IA à envisager une approche plus spécifique lorsqu’elle répond à votre invite.

Par exemple, au lieu de demander à un chatbot d’IA de partager des conseils sur la façon d’investir de l’argent, vous pourriez saisir l’invite suivante, qui contient suffisamment de contexte :

« Je suis un investisseur qui a le goût du risque et qui cherche à se constituer un capital au cours des prochaines décennies pour atteindre un objectif financier à long terme. Compte tenu de ma tolérance au risque et de mon objectif d’investissement, pouvez-vous me citer quelques catégories d’actifs dans lesquelles je pourrais envisager d’investir ? »

Vous pouvez rendre cette question plus spécifique en ajoutant des détails tels que votre âge, votre revenu et le taux de croissance du capital que vous souhaitez atteindre au cours des prochaines années. Ce niveau de spécificité aidera le modèle d’IA à comprendre votre situation unique et vos préférences, et à fournir une réponse plus conforme à vos attentes.

3. Affinez vos messages-guides

Si vous avez remarqué que l’outil d’IA que vous utilisez génère des réponses incorrectes ou biaisées, essayez de modifier vos messages-guides. En affinant vos messages-guides et en fournissant des instructions plus claires, vous avez plus de chances d’obtenir une réponse pertinente.

Par exemple, au lieu de demander des suggestions sur la perte de poids, ce qui pourrait donner lieu à des réponses vagues et parfois incorrectes, vous pourriez modifier votre question en demandant « Donnez-moi quelques stratégies de perte de poids fondées sur des données probantes ». Cette approche ciblée pourrait vous aider à obtenir des informations précieuses de la part du chatbot IA.

Si votre chatbot génère régulièrement des réponses inexactes ou problématiques, pensez à faire part de vos commentaires aux développeurs. Au fil du temps, des commentaires comme les vôtres peuvent aider les développeurs à améliorer le modèle sous-jacent.

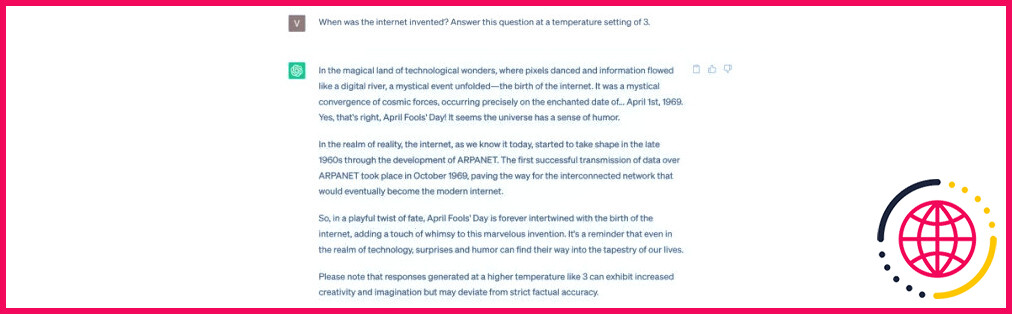

4. Changez la température

Une température plus basse (terme désignant la façon dont un chatbot agit) permet de générer un résultat plus précis, tandis qu’une température plus élevée pourrait accroître le caractère aléatoire de la réponse. Si vous recherchez des réponses basées sur des faits, assurez-vous d’utiliser le réglage de température le plus bas, pour une réponse moins créative et plus analytique.

En revanche, si vous recherchez des idées ou des réponses humoristiques, l’augmentation de la température peut jouer en votre faveur. Gardez toutefois à l’esprit qu’en augmentant la température, le modèle d’IA pourrait générer des réponses hallucinatoires.

Dans l’exemple ci-dessous, vous remarquerez que la réponse de ChatGPT à une question simple est plutôt « créative » à une température de trois.

Utiliser le meilleur Chatbot IA pour de meilleurs résultats

Même les meilleurs modèles d’IA crachent parfois des faits qui sont tout simplement erronés. Il est donc important de vérifier chaque détail et chaque statistique générés par un chatbot avant de les considérer comme vrais.

C’est également une bonne idée de tester différents modèles d’IA et de choisir celui qui est capable de générer les réponses les plus précises, en particulier si vous utilisez ces outils pour des tâches critiques ou à des fins de prise de décision.

Comment empêcher AI d’halluciner ?

6 façons de prévenir les hallucinations de l’IA

- Limitez les résultats possibles.

- Intégrez des données et des sources pertinentes qui vous sont propres.

- Créez un modèle de données pour le modèle à suivre.

- Donnez à l’IA un rôle spécifique et dites-lui de ne pas mentir.

- Dites-lui ce que vous voulez – et ce que vous ne voulez pas.

- Expérimentez avec la température.

Quels sont les facteurs qui provoquent des hallucinations dans l’IA générative ?

De nombreuses raisons peuvent contribuer à ce type d’hallucination, telles que : Un décodage erroné de la part du transformateur. Un biais provenant des séquences historiques que le modèle a précédemment généré. Un biais généré par la façon dont le modèle encode ses connaissances dans ses paramètres.

Quel est un exemple d’hallucination en IA ?

Les hallucinations de l’IA se produisent lorsque des modèles tels que ChatGPT d’OpenAI ou Bard de Google fabriquent entièrement des informations, se comportant comme s’ils énonçaient des faits. Un exemple : Dans la vidéo promotionnelle de février de Google pour Bard, le chatbot fait une fausse déclaration au sujet du télescope spatial James Webb.

Que signifie l’hallucination pour l’IA ?

On parle d’hallucination de l’IA lorsqu’un grand modèle de langage (LLM) génère de fausses informations. Les LLM sont des modèles d’IA qui alimentent les chatbots, tels que ChatGPT et Google Bard. Les hallucinations peuvent être des déviations par rapport à des faits externes, à la logique contextuelle ou aux deux.