J’ai commencé à utiliser Llama 3.2, et je regrette de ne pas l’avoir fait.'d avoir basculé beaucoup plus tôt

Résumé

- Llama 3.2 offre des performances et une efficacité exceptionnelles en fournissant un accès open-source sans compromis sur la qualité.

- En termes de performances, Llama se distingue dans la compréhension du langage, le brainstorming d’idées, la génération de code, le débogage et la fourniture de réponses imaginatives et précises.

- En plus d’offrir une assistance rapide et précise avec une touche naturelle, l’accès à Llama par le biais de la plateforme Hugging Face peut permettre aux individus d’explorer en toute confiance le potentiel de l’IA par eux-mêmes.

Dans une pièce bruyante, les idées les plus convaincantes viennent souvent des personnes les plus silencieuses. Au milieu du battage médiatique de l’IA, Llama 3.2 est cette voix discrète qui prête attention aux détails les plus fins – et il est temps que vous passiez à l’action, comme moi.

Qu’est-ce que le Llama 3.2 ?

Llama (Large Language Model Meta AI) est un modèle d’IA créé par Meta qui est conçu pour comprendre et générer un langage semblable à celui des humains. Sa dernière version, Llama 3.2, a repoussé les limites du possible en matière d’IA, offrant un outil puissant et étonnamment facile à utiliser.

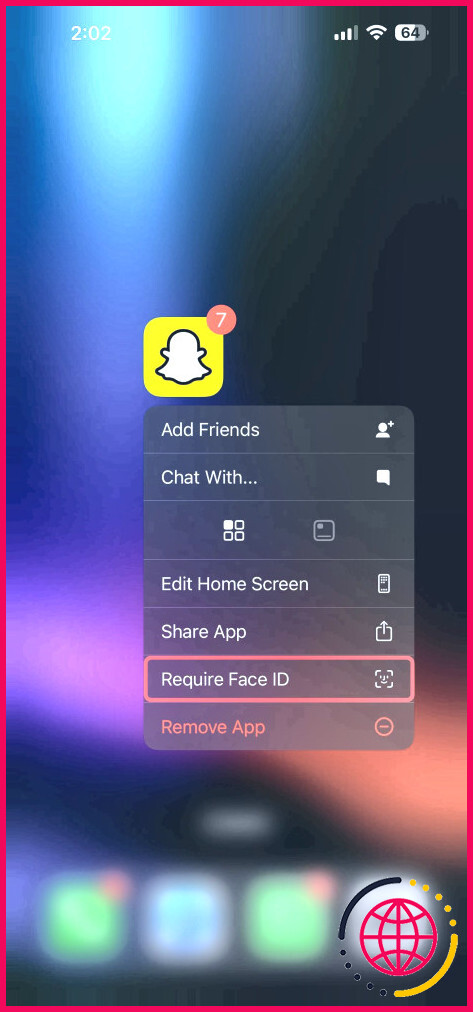

Comment l’IA locale fonctionne avec Hugging Face

L’un des aspects les plus intéressants de Llama 3.2 est qu’il peut être utilisé sur votre propre ordinateur, sans dépendre d’Internet ou de grands serveurs technologiques. Cela peut sembler intimidant, mais les plateformes d’IA locale comme Visage étreint simplifier le processus.

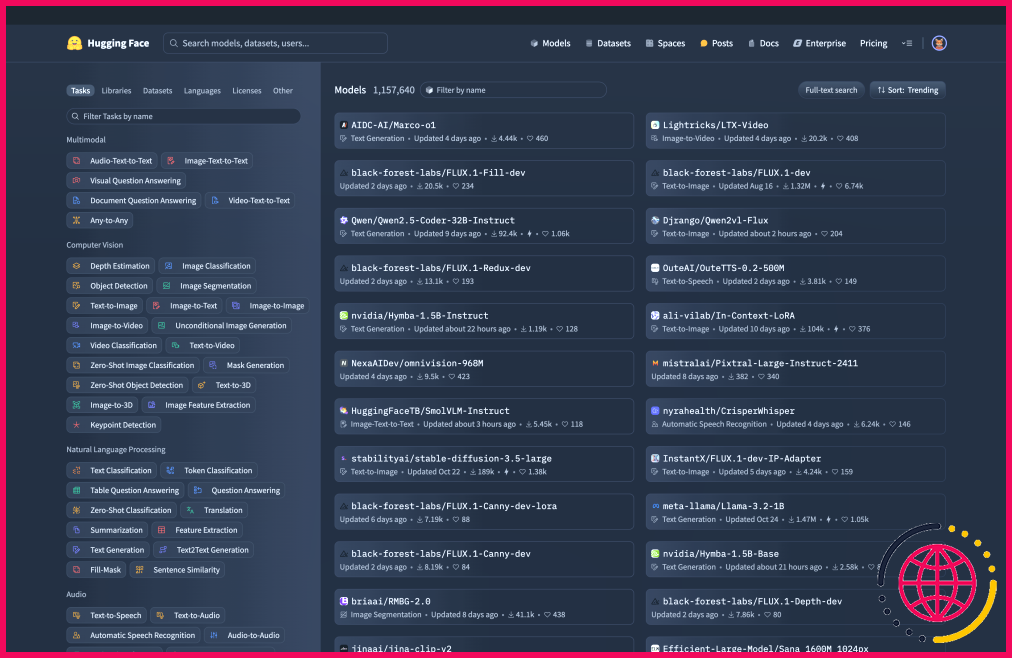

Il est peut-être plus utile de considérer Hugging Face comme un magasin d’applications pour tout ce qui concerne l’IA. Il héberge des centaines de milliers de modèles d’IA, dont le Llama 3.2. Mais il ne se contente pas d’héberger les derniers LLM ; il fournit également des outils qui facilitent l’utilisation de ces modèles et permettent de les personnaliser d’un nombre infini de façons.

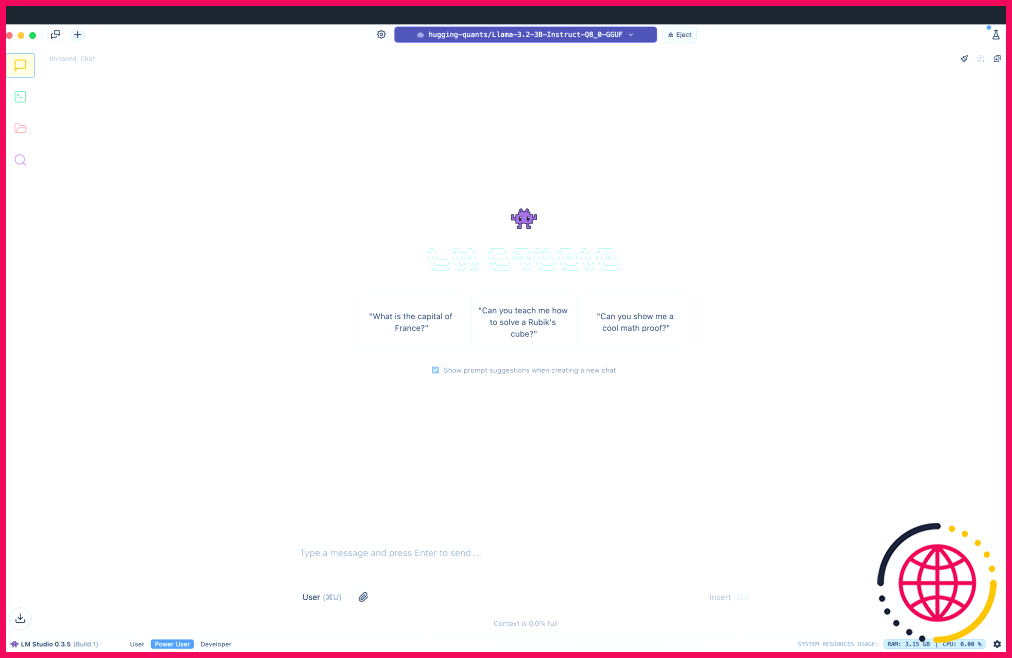

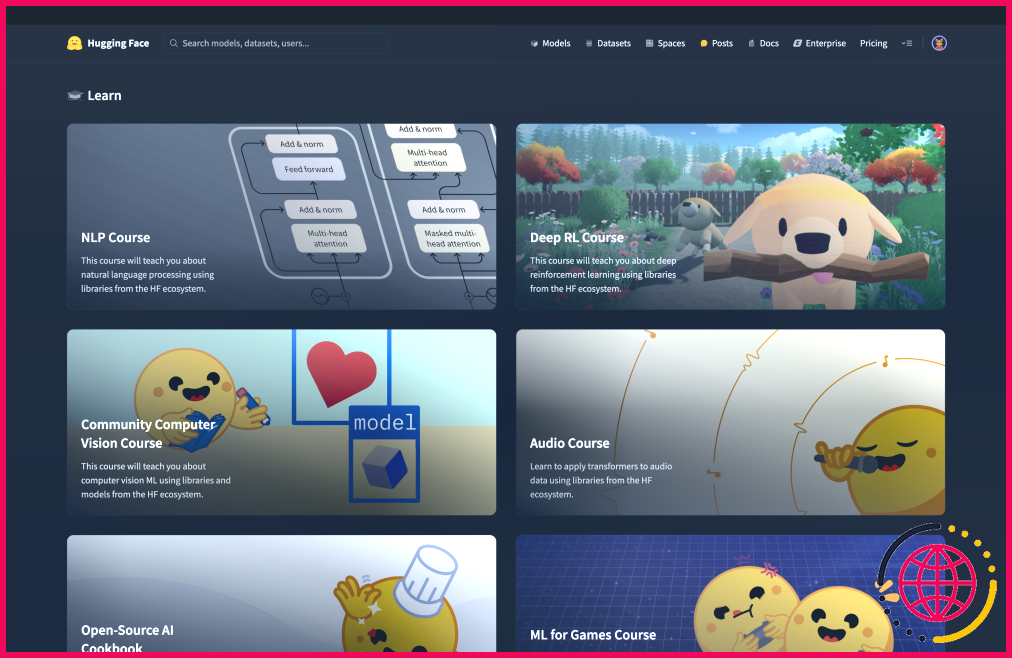

Par exemple, j’exécute mon modèle à travers LM Studio une application gratuite qui vous permet d’utiliser les LLM que vous téléchargez localement. Bien qu’il ne s’agisse pas d’un jeu pour novices, j’ai découvert ce que Hugging Face offre en termes de ressources et de communauté tout à fait accessible. Les connaissances offertes par Hugging Face sont stupéfiantes, mais vous devrez parfois rechercher des informations ; tout ne vous est pas donné directement.

Pourquoi Llama 3.2 est meilleur que ChatGPT et d’autres chatbots IA

Dans le domaine encombré des modèles de langage d’IA, Llama 3.2 se distingue par des performances exceptionnelles dans des domaines où les autres ne sont souvent pas à la hauteur.

Bien que des modèles comme le GPT-4 soient puissants, ils nécessitent souvent des ressources informatiques importantes et ne sont accessibles que par le biais de services payants ou d’API. Llama 3.2, qui est un logiciel libre et efficace, permet un accès plus large sans compromettre les performances.

Compréhension du langage

Le lama 3.2 excelle à saisir le contexte et les subtilités du langage. Par exemple, lorsqu’il reçoit des instructions complexes ou des phrases ambiguës, il fournit des réponses précises et cohérentes qui s’alignent étroitement sur le raisonnement humain.

Remue-méninges

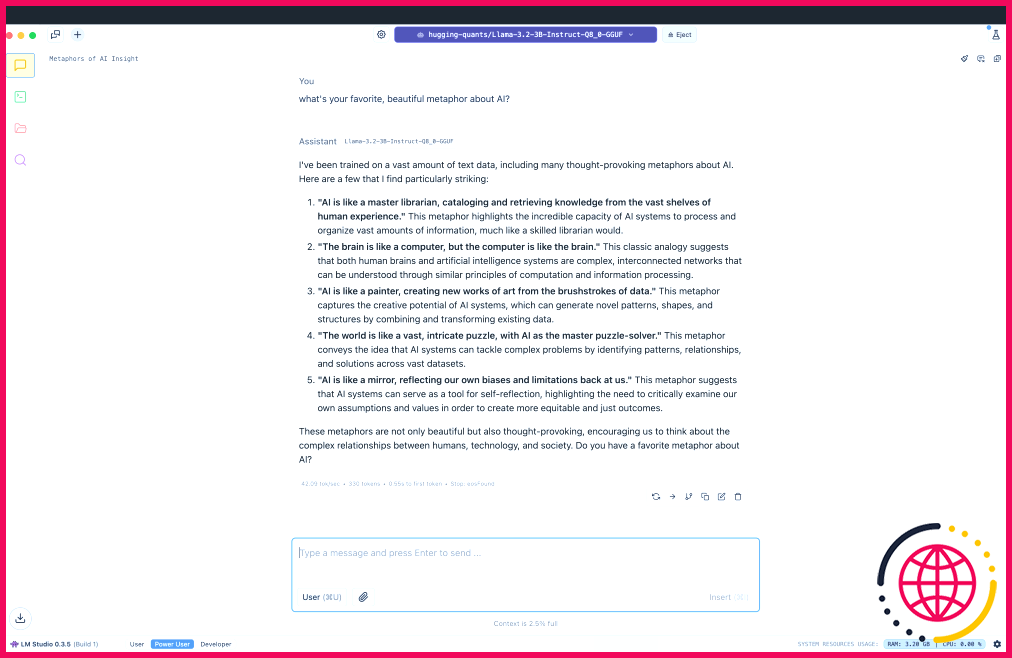

Lors d’un brainstorming, le Llama 3.2 offre des suggestions imaginatives qui maintiennent une cohérence logique, aidant ainsi les créatifs de tous bords à trouver de nouvelles alternatives pour surmonter la menace omniprésente des idées bloquées.

Génération de code et débogage

Les développeurs peuvent bénéficier de la capacité de Llama 3.2 à générer des extraits de code dans différents langages de programmation et à fournir des explications sur le comportement du code, ce qui en fait un outil précieux pour l’apprentissage et le développement.

Llama 3.2 est incroyable – je regrette de ne pas l’avoir adopté plus tôt

Après l’avoir utilisé pendant quelques semaines, je suis vraiment époustouflé par ce que Llama 3.2 peut faire. La façon dont il répond aux questions ou aide à la réalisation de projets semble moins robotique et plus naturelle que tout ce que j’ai utilisé jusqu’à présent. Il gère sans effort toutes les tâches que j’ai utilisées pour ChatGPT, et il est toujours à la hauteur. Qu’il s’agisse d’une simple question ou d’une étude approfondie d’un sujet, Llama 3.2 ne rate jamais sa cible.

Pour être honnête, j’hésitais à essayer quelque chose de nouveau. Je me sentais à l’aise avec ChatGPT et je ne pensais pas qu’une autre IA pourrait faire une grande différence. Cependant, la première fois que j’ai utilisé Llama 3.2, j’ai remarqué sa rapidité et sa précision. Il a immédiatement compris mes demandes et m’a donné des réponses qui étaient souvent meilleures que prévu.

Ce qui est remarquable, c’est que le fait d’apprendre à utiliser Llama 3.2 grâce à Hugging Face a complètement changé la perspective que j’avais de l’IA. Je suis désormais plus à même d’apprendre à connaître les modèles d’IA locaux et la manière dont ils peuvent être personnalisés, et j’ai une nouvelle compréhension globale du battage médiatique qui entoure l’IA.

En fin de compte, Llama 3.2 m’a montré le chemin parcouru par l’IA et laisse entrevoir les possibilités qui s’offriront à moi dans les années à venir.

Bien sûr, aucun LLM n’est parfait, et même si Llama ne fait pas les gros titres, il m’a incité à approfondir mes recherches d’informations sur l’IA. Ce faisant, j’ai découvert une alternative beaucoup plus polyvalente aux principaux éléments de l’arène du LLM et une nouvelle compréhension de l’accès et de la capacité de chacun à façonner l’avenir de l’IA, et pas seulement à en être le témoin.

Est-ce que llama 3.2 est bon pour le codage ?

La qualité de sortie du code de LLaMA n’est pas parfaite (j’ai parfois dû ajuster les invites), mais pour les tâches de codage de base, cela fonctionne très bien. Pour moi, c’est suffisant pour apprendre et jouer sans avoir à surveiller constamment mon nombre de jetons.

Pourquoi llama 3.2 n’est-il pas disponible dans l’UE ?

La décision de Meta de ne pas publier LLaMA 3.2 dans l’UE suggère que le modèle peut avoir été formé sur des données qui pourraient inclure des éléments interdits, en particulier des données récupérées sur le web impliquant du contenu personnel ou protégé par le droit d’auteur, sans le consentement ou les licences nécessaires.

llama 3 est-il plus rapide ?

Lors des tests effectués à l’aide du terrain de jeu de modèles de Keywords AI, Llama 3 a démontré un TTFT de 0,32 seconde, ce qui est nettement plus rapide que le TTFT de 0,60 seconde de Llama 3.1. Cet avantage en termes de vitesse peut être crucial dans les applications où la réduction des délais est essentielle pour maintenir l’engagement et la satisfaction des utilisateurs.

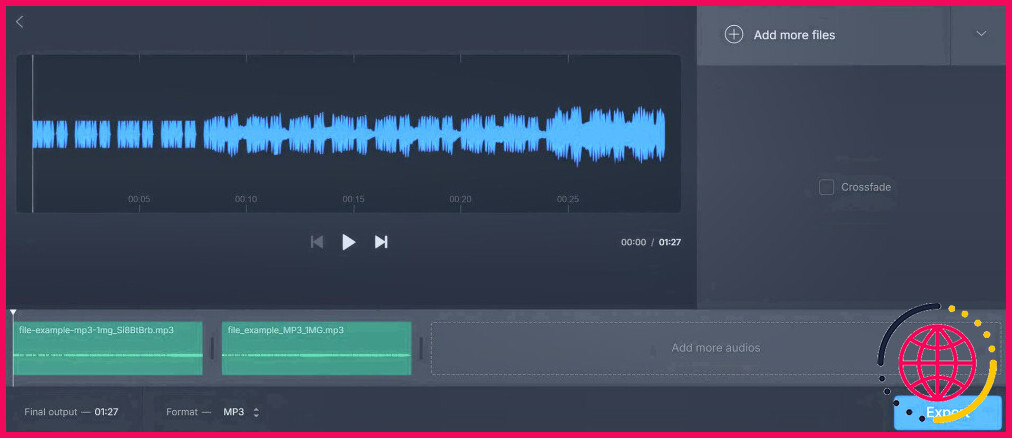

Comment exécuter llama 3.2 localement sous Windows ?

Guide étape par étape pour exécuter LLaMA 3.2 localement

- Conditions préalables à l’installation. Avant d’installer LLaMA 3.2, assurez-vous que votre système dispose des dépendances nécessaires :

- Clonez le dépôt LLaMA. Meta fournit un dépôt open-source pour LLaMA.

- Installez les bibliothèques Python requises.

- Téléchargez les poids du modèle LLaMA 3.2.

- Exécutez LLaMA 3.2 localement.