5 raisons pour lesquelles les entreprises interdisent le ChatGPT

Malgré ses capacités impressionnantes, plusieurs grandes entreprises ont interdit à leurs employés d’utiliser ChatGPT.

En mai 2023, Samsung a interdit l’utilisation de ChatGPT et d’autres outils d’IA générative. Puis, en juin 2023, la Commonwealth Bank of Australia a fait de même, ainsi que des entreprises comme Amazon, Apple et JPMorgan Chase & Co. Certains hôpitaux, cabinets d’avocats et agences gouvernementales ont également interdit à leurs employés d’utiliser ChatGPT.

Alors, pourquoi de plus en plus d’entreprises interdisent-elles ChatGPT ? Voici cinq raisons principales.

1. Fuites de données

Le ChatGPT a besoin d’une grande quantité de données pour être formé et fonctionner efficacement. Le chatbot a été formé en utilisant des quantités massives de données dérivées de l’internet, et il continue à être formé.

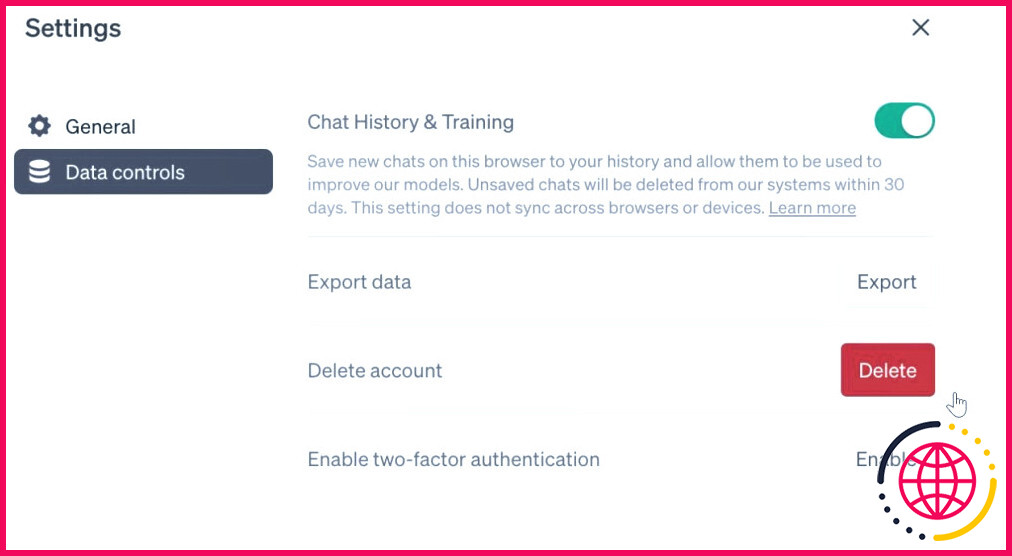

Selon Page d’aide d’OpenAI, chaque donnée, y compris les détails confidentiels sur les clients, les secrets commerciaux et les informations commerciales sensibles que vous fournissez au chatbot est susceptible d’être examinée par ses formateurs, qui peuvent utiliser vos données pour améliorer leurs systèmes.

De nombreuses entreprises sont soumises à des réglementations strictes en matière de protection des données. Par conséquent, elles sont prudentes lorsqu’il s’agit de partager des données personnelles avec des entités externes, car cela augmente les risques de fuites de données.

En outre, OpenAI n’offre aucune garantie infaillible en matière de protection des données et de confidentialité. En mars 2023, OpenAI a confirmé un bogue permettant à certains utilisateurs de voir les titres des conversations dans l’historique d’autres utilisateurs actifs. Bien que ce bogue ait été corrigé et qu’OpenAI ait lancé un programme de récompense des bogues, l’entreprise ne garantit pas la sécurité et la confidentialité des données des utilisateurs.

De nombreuses organisations choisissent de restreindre l’utilisation de ChatGPT par leurs employés afin d’éviter les fuites de données, qui peuvent nuire à leur réputation, entraîner des pertes financières et mettre en danger leurs clients et leurs employés.

2. Risques liés à la cybersécurité

Bien qu’il ne soit pas certain que ChatGPT soit réellement sujet à des risques de cybersécurité, il est possible que son déploiement au sein d’une organisation introduise des vulnérabilités potentielles que les cyber-attaquants peuvent exploiter.

Si une entreprise intègre ChatGPT et qu’il y a des faiblesses dans le système de sécurité du chatbot, les attaquants peuvent être en mesure d’exploiter les vulnérabilités et d’injecter des codes malveillants. En outre, la capacité de ChatGPT à générer des réponses ressemblant à celles d’un humain est un œuf d’or pour les attaquants par hameçonnage qui peuvent prendre le contrôle d’un compte ou se faire passer pour des entités légitimes afin de tromper les employés de l’entreprise et les amener à partager des informations sensibles.

3. Création de Chatbots personnalisés

Malgré ses caractéristiques innovantes, le ChatGPT peut produire des informations fausses et trompeuses. C’est pourquoi de nombreuses entreprises ont créé des chatbots d’IA à des fins professionnelles. Par exemple, la Commonwealth Bank of Australia a demandé à ses employés d’utiliser Gen.ai à la place, un chatbot d’intelligence artificielle (IA) qui utilise les informations de CommBank pour fournir des réponses.

Des entreprises comme Samsung et Amazon ont développé des modèles avancés de langage naturel, de sorte que les entreprises peuvent facilement créer et déployer des chatbots personnalisés basés sur des transcriptions existantes. Grâce à ces chatbots internes, vous pouvez éviter les conséquences juridiques et les atteintes à la réputation liées à une mauvaise manipulation des données.

4. Absence de réglementation

Dans les secteurs où les entreprises sont soumises à des protocoles réglementaires et à des sanctions, l’absence d’orientation réglementaire de ChatGPT est un signal d’alarme. Sans conditions réglementaires précises régissant l’utilisation de ChatGPT, les entreprises peuvent faire face à de graves conséquences juridiques lorsqu’elles utilisent le chatbot IA pour leurs opérations.

En outre, l’absence de réglementation peut diminuer la responsabilité et la transparence d’une entreprise. La plupart des entreprises ne savent pas comment expliquer à leurs clients les processus décisionnels et les mesures de sécurité du modèle linguistique d’IA.

Les entreprises limitent le ChatGPT, craignant des violations potentielles des lois sur la protection de la vie privée et des réglementations spécifiques à l’industrie.

5. Utilisation irresponsable par les employés

Dans de nombreuses entreprises, certains employés s’appuient uniquement sur les réponses du ChatGPT pour générer du contenu et accomplir leurs tâches. Cela engendre de la paresse dans l’environnement de travail et freine la créativité et l’innovation.

La dépendance à l’égard de l’IA peut nuire à la capacité de penser de manière critique. Cela peut également nuire à la crédibilité d’une entreprise, car ChatGPT fournit souvent des données inexactes et peu fiables.

Bien que ChatGPT soit un outil puissant, son utilisation pour répondre à des requêtes complexes nécessitant une expertise spécifique peut nuire au fonctionnement et à l’efficacité d’une entreprise. Certains employés peuvent ne pas se souvenir de vérifier les faits et les réponses fournies par le chatbot IA, considérant les réponses comme une solution unique.

Pour atténuer les problèmes de ce type, les entreprises interdisent le chatbot afin que les employés puissent se concentrer sur leurs tâches et fournir aux utilisateurs des solutions exemptes d’erreurs.

Interdiction du ChatGPT : Mieux vaut prévenir que guérir

Les entreprises qui interdisent le ChatGPT indiquent des risques de cybersécurité, des normes éthiques pour les employés et des défis de conformité réglementaire. L’incapacité de ChatGPT à atténuer ces défis tout en fournissant des solutions sectorielles atteste de ses limites et de la nécessité d’évoluer davantage.

En attendant, les entreprises se tournent vers d’autres chatbots ou interdisent simplement à leurs employés d’utiliser ChatGPT afin d’éviter les violations de données potentielles et les protocoles de sécurité et de réglementation peu fiables associés au chatbot.

Pourquoi les entreprises n’autorisent-elles pas le ChatGPT ?

iHeartMedia rejoint une liste croissante d’entreprises qui restreignent considérablement ou interdisent l’utilisation de ChatGPT et d’autres outils d’IA générative par les employés – en grande partie parce qu’elles craignent que le chatbot puisse divulguer des informations confidentielles.

Quelles sont les entreprises qui ont interdit ChatGPT ?

D’autres banques, dont Bank of America, Citigroup, Deutsche Bank, Goldman Sachs, Wells Fargo & Co, et JP Morgan, ont carrément interdit l’utilisation de ChatGPT. Le cabinet comptable PwC a encouragé son personnel à jouer avec ChatGPT, mais l’a averti de ne pas utiliser le programme pour le travail de ses clients.

Pourquoi Amazon a-t-il interdit ChatGPT ?

Amazon a averti ses employés de ne pas partager de code avec le chatbot d’IA ChatGPT. L’entreprise craint que le robot puisse être utilisé pour accéder à des informations confidentielles et les voler. Cet avertissement intervient après que ChatGPT ait été capable de générer des réponses imitant les données internes d’Amazon.