Qu’est-ce que la puce R1 d’Apple et comment se compare-t-elle aux puces M1 et M2 ?

Le Vision Pro intègre une nouvelle puce Apple, la puce R1, dédiée au traitement en temps réel des données provenant de tous les capteurs embarqués. Elle est responsable du suivi des yeux, des mains et de la tête, du rendu sans décalage de l’environnement de l’utilisateur en mode vidéo passthrough et d’autres fonctionnalités de visionOS.

En déchargeant le processeur principal de la charge de traitement et en optimisant les performances, le R1 réduit le mal des transports à des niveaux imperceptibles, que le casque soit utilisé en mode réalité augmentée ou en mode réalité virtuelle. Explorons le fonctionnement de la puce Apple R1 et sa comparaison avec la puce principale M2, les fonctionnalités Vision Pro qu’elle permet, et plus encore.

Qu’est-ce que la puce R1 d’Apple ? Comment fonctionne-t-elle ?

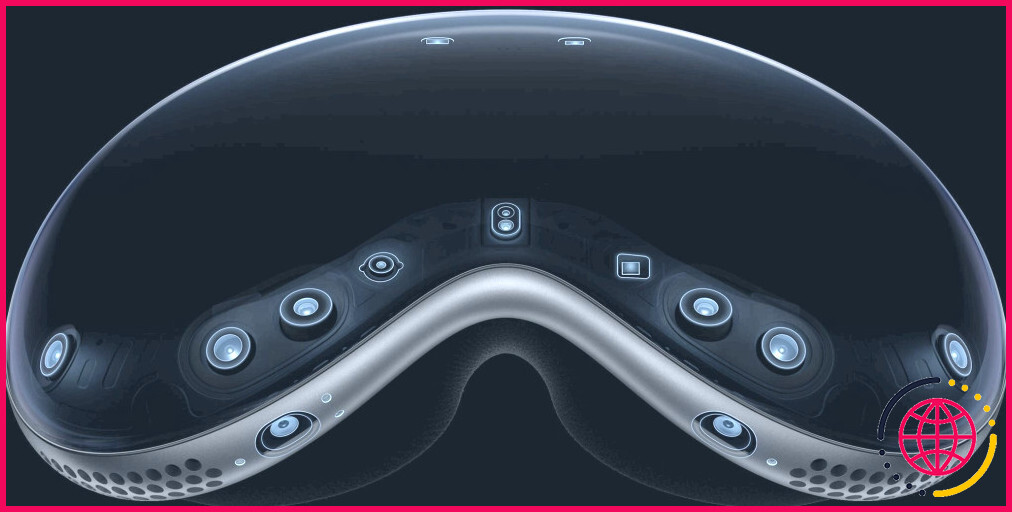

La puce Apple R1, et non la puce principale M2, traite un flux continu de données en temps réel transmises à Vision Pro par ses douze caméras, cinq capteurs et six microphones.

Deux caméras externes principales enregistrent votre monde, envoyant plus d’un milliard de pixels sur les écrans 4K du casque chaque seconde. En outre, une paire de caméras latérales, ainsi que deux caméras inférieures et deux illuminateurs infrarouges, suivent les mouvements de la main dans un large éventail de positions, même dans des conditions de faible luminosité.

Les capteurs orientés vers l’extérieur comprennent également le scanner LiDAR et la caméra TrueDepth d’Apple qui capturent une carte de profondeur de votre environnement, permettant à Vision Pro de positionner les objets numériques avec précision dans votre espace. À l’intérieur, un anneau de LED autour de chaque écran et deux caméras infrarouges suivent le mouvement de vos yeux, ce qui constitue la base de la navigation de VisionOS.

Le R1 est chargé de traiter les données de tous ces capteurs, y compris les unités de mesure inertielle, avec un retard imperceptible. Ceci est de la plus haute importance pour rendre l’expérience spatiale fluide et crédible.

Comment l’Apple R1 se compare-t-il au M1 et au M2 ?

Les M1 et M2 sont des processeurs à usage général optimisés pour les ordinateurs Mac. Le R1 est un coprocesseur à focalisation étroite conçu pour prendre en charge des expériences AR fluides. Il fait son travail plus rapidement que le M1 ou le M2, ce qui permet de bénéficier d’avantages tels qu’une expérience sans décalage.

Apple n’a pas précisé combien de cœurs de CPU et de GPU le R1 possède, ni détaillé la fréquence du CPU et la RAM, ce qui rend difficile une comparaison directe entre le R1, le M1 et le M2.

Les principaux domaines du R1 sont le suivi des yeux et de la tête, les gestes de la main et la cartographie 3D en temps réel via le capteur LiDAR. Le fait de décharger ces opérations à forte intensité de calcul permet au M2 d’exécuter efficacement les différents sous-systèmes, algorithmes et applications de visionOS.

Les principales caractéristiques de la puce R1 du Vision Pro

La puce R1 présente les principales caractéristiques suivantes

- Traitement rapide : Les algorithmes spécialisés et le traitement du signal d’image dans le R1 sont optimisés pour comprendre les entrées du capteur, de la caméra et du microphone.

- Faible latence : L’architecture matérielle optimisée se traduit par une très faible latence.

- Efficacité énergétique : Le R1 gère un ensemble particulier de tâches tout en consommant un minimum d’énergie, grâce à son architecture mémoire efficace et au processus de fabrication TSMC en 5 nm.

En revanche, la conception à double puce du Vision Pro et la sophistication du R1 contribuent au prix élevé du casque et à son autonomie de deux heures.

Quels sont les avantages du R1 par rapport au Vision Pro ?

Le R1 permet un suivi précis des yeux et des mains qui « fonctionne ». Pour naviguer dans visionOS, par exemple, vous dirigez votre regard vers des boutons et d’autres éléments.

Le Vision Pro utilise les gestes de la main pour sélectionner des éléments, faire défiler, etc. La sophistication et la précision du suivi des yeux et des mains ont permis aux ingénieurs d’Apple de créer un casque de réalité mixte ne nécessitant aucun contrôleur physique.

La précision du suivi et le délai minimal du R1 permettent des fonctions supplémentaires, comme la frappe aérienne sur le clavier virtuel. Le R1 permet également un suivi fiable de la tête, essentiel pour créer une toile informatique spatiale autour de l’utilisateur. Là encore, la précision est essentielle : vous voulez que tous les objets AR conservent leur position, quelle que soit la façon dont vous inclinez et tournez votre tête.

La conscience spatiale est un autre facteur qui contribue à l’expérience. Le R1 prend les données de profondeur du capteur LiDAR et de la caméra TrueDepth, réalisant ainsi une cartographie 3D en temps réel. Les informations de profondeur permettent au casque de comprendre son environnement, comme les murs et les meubles.

Ces informations sont importantes pour la persistance de la RA, c’est-à-dire le placement fixe d’objets virtuels. Elles permettent également à Vision Pro d’avertir l’utilisateur avant qu’il ne se heurte à des objets physiques, ce qui contribue à réduire le risque d’accident dans les applications de réalité augmentée.

Comment la fusion du capteur R1 atténue-t-elle le mal des transports en RA ?

La conception à double puce du Vision Pro décharge le traitement des capteurs de la puce principale M2, qui exécute le système d’exploitation visionOS et les applications. Selon le communiqué de presse de Vision Pro le R1 transmet les images des caméras externes aux écrans internes en 12 millisecondes, soit huit fois plus vite qu’un clignement d’œil, ce qui minimise le décalage.

Le décalage fait référence à la latence entre ce que les caméras voient et les images affichées sur les écrans 4K du casque. Plus le délai est court, mieux c’est.

Le mal des transports survient lorsqu’il y a un décalage perceptible entre les données que votre cerveau reçoit de vos yeux et ce que votre oreille interne perçoit. Il peut survenir dans de nombreuses situations, notamment dans un parc d’attractions, sur un bateau ou une croisière, lors de l’utilisation d’un dispositif VR, etc.

La RV peut rendre les gens malades en raison du conflit sensoriel, ce qui entraîne des symptômes de mal des transports tels que la désorientation, la nausée, les vertiges, les maux de tête, la fatigue oculaire, l’assise, les vomissements, etc.

La RV peut également être mauvaise pour les yeux en raison de la fatigue oculaire, dont les symptômes comprennent des douleurs ou des démangeaisons oculaires, une vision double, des maux de tête et une nuque douloureuse. Certaines personnes peuvent ressentir un ou plusieurs de ces symptômes pendant plusieurs heures après avoir enlevé le casque.

En règle générale, un dispositif de RV doit rafraîchir l’affichage au moins 90 fois par seconde (FPS), et le délai de l’écran doit être inférieur à 20 millisecondes pour éviter de donner le mal des transports.

Avec un décalage de seulement 12 millisecondes, le R1 réduit le décalage à un niveau imperceptible. Bien que le R1 contribue à minimiser les effets du mal des transports, certains testeurs du Vision Pro ont signalé des symptômes de mal des transports après avoir porté le casque pendant plus de 30 minutes.

Les coprocesseurs en silicium spécialisés d’Apple apportent des avantages majeurs

Apple n’est pas étranger aux processeurs spécialisés. Au fil des ans, son équipe chargée du silicium a produit des puces mobiles et de bureau qui font l’envie de l’industrie.

Les puces au silicium d’Apple s’appuient fortement sur des coprocesseurs spécialisés pour gérer des fonctions spécifiques. Le Secure Enclave gère en toute sécurité les données biométriques et de paiement, par exemple, tandis que le Neural Engine accélère les fonctions d’IA sans détruire la batterie.

Ce sont des exemples parfaits de ce que l’on peut obtenir en ayant un coprocesseur très ciblé pour le bon ensemble de tâches plutôt que d’utiliser le processeur principal pour tout.