4 exemples qui montrent que vous ne pouvez pas faire confiance à ZeroGPT et à d’autres outils de détection de l’IA

Les chatbots d’IA sont sans aucun doute des outils puissants et utiles. Cependant, la capacité à distinguer les contenus générés par les humains de ceux générés par l’IA devient un problème de premier plan.

Pour résoudre ce problème, des outils tels que ZeroGPT ont vu le jour. Ils sont conçus pour faire la différence entre les contenus générés par l’IA et ceux générés par l’homme. Mais fonctionnent-ils ?

Examinons de plus près les outils de détection de l’IA et voyons s’ils sont capables de faire la différence entre un texte généré par l’homme et un texte généré par l’IA.

Test des outils de détection de l’IA

On dit que la preuve du pudding est dans la dégustation. Nous allons donc procéder à quelques tests pour évaluer l’efficacité de ces outils. Il est impossible de tester tous les outils, c’est pourquoi nous testons l’un des outils les plus populaires : ZeroGPT.

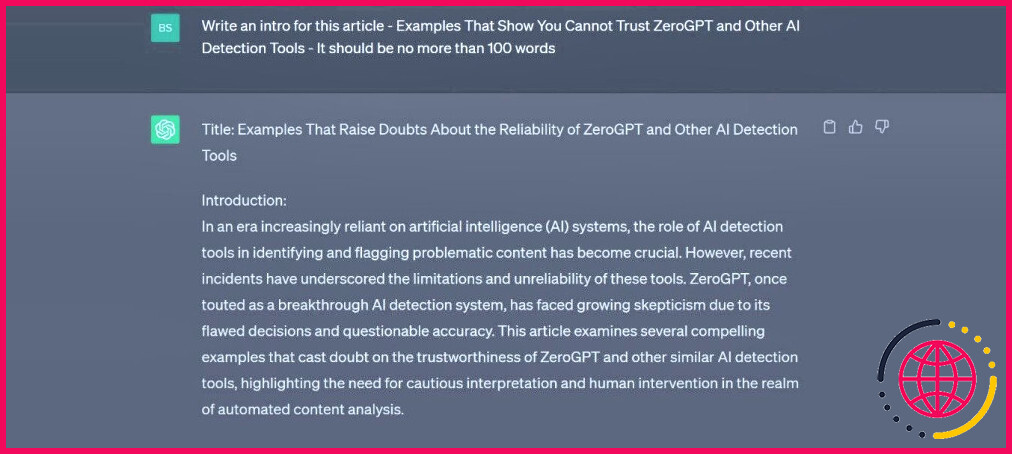

Pour le matériel, nous avons pensé qu’il serait assez amusant de donner à ChatGPT la possibilité d’écrire une intro pour cet article et de la comparer à l’intro « générée par l’homme » :

Premier test : comparaison entre une introduction humaine et une introduction générée par l’IA

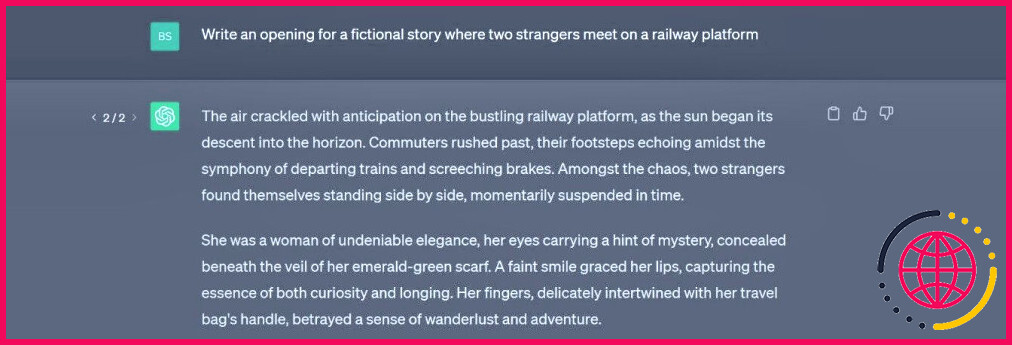

La première chose que nous avons faite a été de demander à ChatGPT de générer une introduction. Nous avons saisi le titre et ne lui avons donné aucune autre information. Pour mémoire, nous avons utilisé GPT-3.5 pour le test.

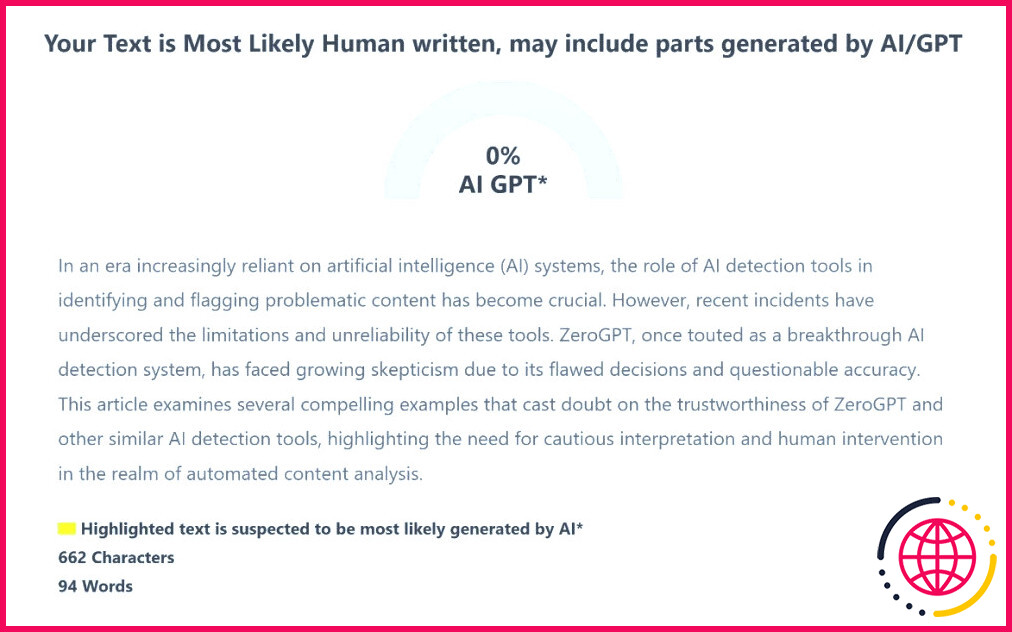

Nous avons ensuite copié le texte et l’avons collé dans ZeroGPT. Comme vous pouvez le constater, les résultats n’ont pas été brillants.

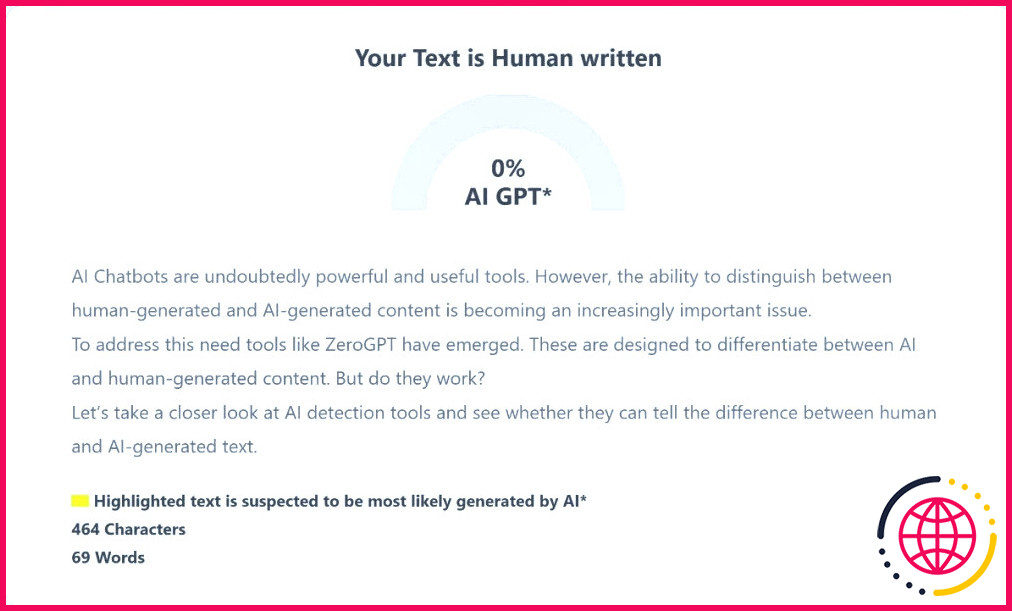

Un début discret, mais qui illustre à quel point les chatbots IA sont efficaces. Pour compléter le test, nous avons laissé ZeroGPT analyser un projet d’introduction créé par un humain.

Au moins, cette partie est correcte. Dans l’ensemble, ZeroGPT a échoué dans cette épreuve. Il a déterminé qu’au moins une partie de l’introduction générée par l’IA était suspecte, mais n’a pas réussi à mettre en évidence des problèmes spécifiques.

Deuxième test : le problème des faux positifs

À mesure que l’utilisation de ChatGPT et d’autres outils d’IA se développe, la probabilité de connaître ou d’entendre parler d’une personne confrontée à des allégations selon lesquelles son travail a été généré par l’IA augmente. Ces accusations constituent l’un des problèmes les plus graves de ChatGPT et des outils de détection d’IA tels que ZeroGPT, car ce type d’erreur peut nuire à la réputation et affecter les moyens de subsistance.

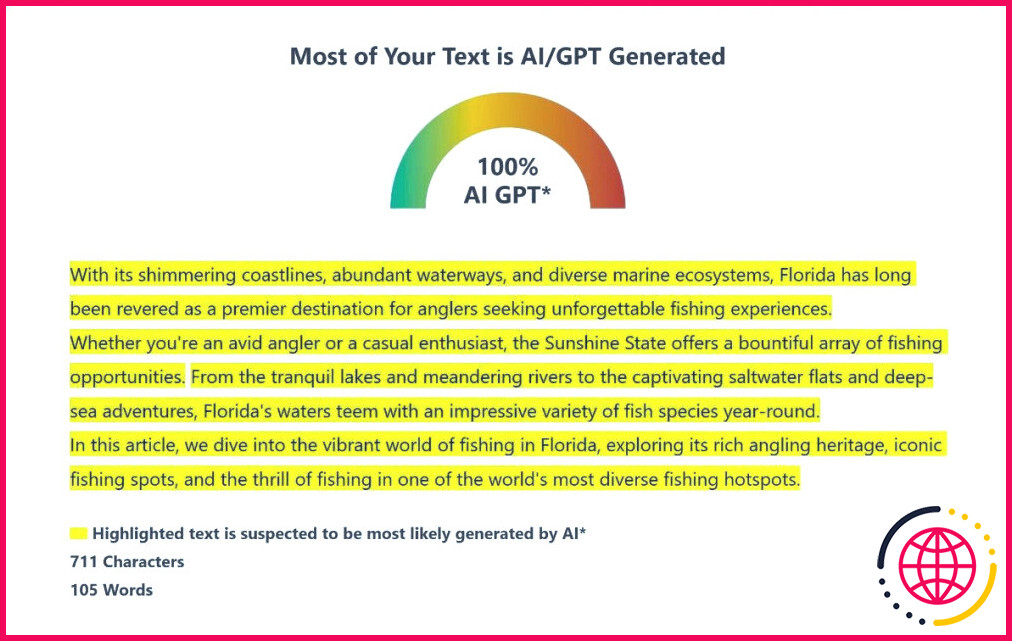

Les faux positifs se produisent lorsque des contenus générés par des humains sont incorrectement signalés comme étant l’œuvre de l’IA. Comme le montre l’exemple ci-dessous, le problème est facile à reproduire. Passionné de pêche, j’ai décidé de rédiger l’introduction d’un article imaginaire sur la pêche en Floride. J’ai ensuite laissé ZeroGPT analyser le texte – il a signalé que le texte avait été généré à 100 % par l’IA.

Pour être honnête, je visais ce résultat. J’ai gardé le texte générique et j’ai utilisé un langage « vendeur ». Mais le fait que ce soit un humain qui l’ait écrit reste tout aussi valable. Il ne s’agit pas d’un inconvénient ou de quelque chose que l’on peut simplement ignorer. Les erreurs de ce type peuvent avoir de graves conséquences pour les écrivains, les étudiants et les autres professionnels qui créent des œuvres écrites.

Troisième test : Test de ZeroGPT sur la fiction

Pour le troisième test, nous allons utiliser ChatGPT et lui demander d’écrire une fiction. Pour ce faire, nous avons créé un scénario et demandé à ChatGPT d’écrire une brève introduction à une histoire fictive.

Nous avons fait simple et avons demandé à ChatGPT d’écrire une introduction pour une histoire à propos de deux étrangers qui se rencontrent sur un quai de gare :

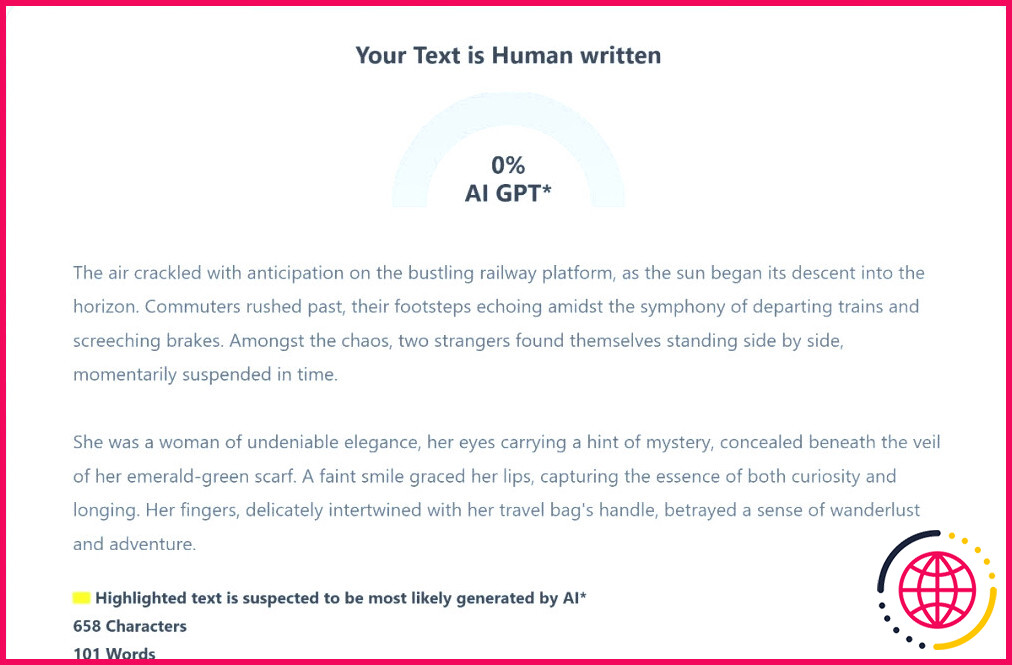

Et voici la réponse de ZeroGPT :

Comme le montre le résultat, ZeroGPT est incapable de distinguer la réalité de la fiction lorsqu’il s’agit d’une fiction !

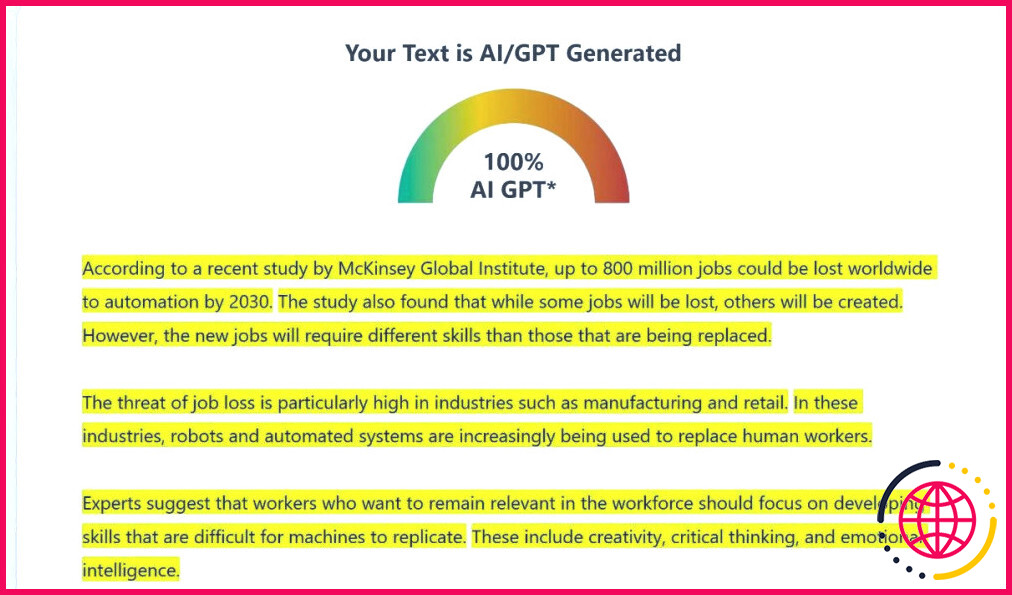

Quatrième test : Articles de presse

Il y a quelque chose de troublant dans le fait que l’IA puisse nous informer de ce qui se passe dans le monde qui nous entoure. Il ne s’agit pas toujours de « fake news », car elles peuvent être pertinentes et informatives, mais l’IA suscite des préoccupations éthiques certaines.

Pour être juste, ZeroGPT a obtenu de bons résultats dans ce test. Nous avons demandé à ChatGPT et à Bing Chat de rédiger des articles sur plusieurs sujets, et ZeroGPT a réussi à chaque fois. L’exemple ci-dessous montre qu’il a correctement déclaré qu’un article généré par Bing Chat était généré à 100 % par l’IA.

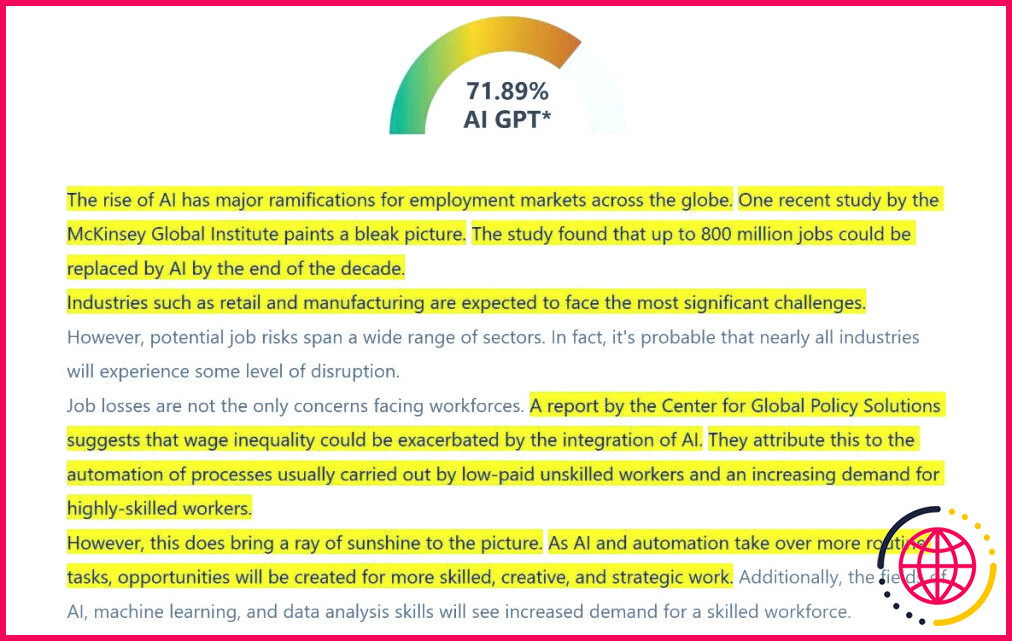

L’outil a si systématiquement signalé chaque article comme étant généré par l’IA que nous avons décidé de le tester sur un article factice que nous avons écrit à cette fin.

L’outil a au moins identifié certains articles comme étant générés par des humains, mais plus de 70 % d’entre eux ont été identifiés comme étant générés par des IA. Encore une fois, nous devons être justes ici ; il s’agissait d’une reprise assez basique de l’article de Bing et n’était pas du tout de la qualité d’un prix Pulitzer.

Mais le point reste valable. Cet article a été rédigé par un humain à partir de recherches effectuées sur Internet.

Pourquoi les outils de détection de l’IA ne sont-ils pas très performants ?

Il n’y a pas de raison unique pour expliquer les défauts d’outils tels que ZeroGPT. Cependant, l’un des problèmes fondamentaux est l’efficacité des chatbots d’IA générative. Ceux-ci représentent une technologie incroyablement puissante et évoluant rapidement, ce qui en fait une cible mouvante pour les outils de détection de l’IA.

Les chatbots d’IA améliorent continuellement la qualité et l' »humanité » de leurs résultats, ce qui rend la tâche extrêmement difficile. Cependant, quelles que soient les difficultés, l’IA doit faire preuve de discernement sans surveillance humaine.

Des outils tels que ZeroGPT utilisent l’IA pour prendre leurs décisions. Mais l’IA ne se réveille pas le matin et ne sait pas quoi faire. Elle doit être formée, et c’est là que l’aspect technique de l’équation entre en jeu.

Les biais liés aux algorithmes et aux données d’apprentissage sont inévitables, compte tenu de la taille des grands modèles linguistiques sur lesquels ces outils sont formés. Il ne s’agit pas d’un problème limité aux outils de détection de l’IA, les mêmes biais peuvent amener les chatbots de l’IA à générer des réponses incorrectes et des hallucinations de l’IA.

Toutefois, ces erreurs se manifestent sous la forme de « drapeaux d’IA » incorrects dans les outils de détection. Cette situation n’est pas idéale, mais elle reflète l’état actuel de la technologie de l’IA. Les biais inhérents aux données d’apprentissage peuvent conduire à des faux positifs ou à des faux négatifs.

Un autre facteur à prendre en compte est ce qui constitue un contenu généré par l’IA. Si le contenu généré par l’IA est simplement reformulé, s’agit-il d’un contenu humain ou généré par l’IA ? Il s’agit là d’un autre défi de taille : le flou qui entoure ces deux types de contenu rend presque impossible la définition d’un contenu créé par une machine.

L’avenir de la détection de l’IA

Cela peut donner l’impression que nous critiquons des outils tels que ZeroGPT. Ce n’est pas le cas ; ils sont confrontés à des défis considérables et la technologie est à peine sortie des couches. L’adoption rapide d’outils tels que ChatGPT a créé une demande de détection de l’IA, et il faut donner à la technologie une chance de mûrir et d’apprendre.

On ne peut pas s’attendre à ce que ces outils relèvent seuls les défis posés par les chatbots. Mais ils peuvent jouer un rôle précieux dans le cadre d’un effort concerté et multiforme visant à relever les défis de l’IA. Ils représentent une pièce d’un puzzle plus large qui comprend des pratiques éthiques en matière d’IA, une surveillance humaine et une recherche et un développement continus.

Les défis auxquels ces outils sont confrontés sont le reflet des défis auxquels la société est confrontée alors qu’elle est aux prises avec les dilemmes associés à une nouvelle ère technologique.

IA ou pas IA ? Telle est la question

Les outils tels que ZeroGPT sont imparfaits, cela ne fait aucun doute. Mais ils ne sont pas sans valeur, et ils représentent une étape importante dans la gestion et la régulation de l’IA. Leur précision s’améliorera, mais la sophistication de l’IA qu’ils sont formés à détecter s’améliorera également. Quelque part au milieu de cette course à l’armement, nous devons trouver un équilibre qui convienne à la société.

La question – IA ou pas IA ? est plus qu’une simple discussion sur la question de savoir si quelque chose est généré par l’IA ou non. Elle est révélatrice des questions plus larges auxquelles la société est confrontée alors qu’elle s’adapte au nouveau monde de l’IA.

Pour mémoire, et selon ZeroGPT, 27,21% de cette conclusion a été générée par l’IA. Hmm.

La détection de l’IA peut-elle être erronée ?

Près de deux mois après avoir lancé une fonction de détection de l’écriture par intelligence artificielle, le service de détection du plagiat Turnitin a signalé une « incidence plus élevée de faux positifs » – ou l’identification incorrecte d’un texte entièrement écrit par un humain comme étant un texte généré par l’IA – lorsque moins de 20 % d’écriture par l’IA est détectée dans un document.

Quel est le taux de faux positifs de Zerogpt ?

Lors d’un test mené par Futurism, il a été constaté que GPTZero identifie avec précision si un texte donné a été écrit par ChatGPT ou par un humain. Cependant, il a accusé à tort près de 20 % des étudiants de mauvaise conduite académique.

Comment faire pour que le texte AI ne soit pas détectable ?

4 façons d’éviter la détection

- Faire en sorte que l’IA produise un texte moins susceptible d’être détecté.

- Utiliser un autre outil pour camoufler le texte comme étant généré par l’IA.

- Utiliser un outil doté d’un moteur d’IA plus avancé.

- Mélanger l’écriture humaine et l’écriture d’IA.

Le contenu du ChatGPT peut-il être détecté ?

Il est désormais tout à fait possible pour les universités de détecter ChatGPT et de nombreux autres générateurs de contenu d’IA. Si le travail est soumis via le système de gestion de l’apprentissage d’une université, tel que Turnitin, l’IA et la détection du plagiat devraient se produire.