HDR vs. SDR : quelle est la différence ?

La technologie moderne HDR est actuellement si répandue que les services de streaming préférés tels que Amazon Prime, Disney+, ainsi que Netflix ont commencé à soutenir le contenu Web HDR. En fait, si vous deviez chercher un nouveau téléviseur ou un écran aujourd’hui, vous seriez surpris de voir à quel point presque tous les produits se vantent de la HDR sur leur liste de spécifications.

Ce qui amène à se demander : qu’est-ce que le HDR exactement ? Comment fonctionne exactement la HDR, et aussi comment se compare-t-elle à la SDR ordinaire ?

Qu’est-ce que la SDR ?

La gamme dynamique standard (SDR) est une exigence du clip vidéo qui a effectivement été utilisé parce que les écrans CRT. Malgré le succès commercial de la technologie moderne des écrans HDR, SDR est toujours le format par défaut utilisé dans les téléviseurs, les moniteurs et aussi les projecteurs. Bien qu’il ait été utilisé dans les anciens écrans à tube cathodique (et qu’il soit réellement entravé par les contraintes de la technologie moderne du tube cathodique), le SDR est toujours un format approprié aujourd’hui. En fait, la grande majorité du contenu Web des clips vidéo, qu’il s’agisse de jeux vidéo, de films ou de vidéos YouTube, utilise toujours le SDR. Principalement, si l’appareil ou le matériel n’est pas classé comme HDR, vous utilisez très probablement SDR.

Qu’est-ce que la HDR ?

La gamme dynamique élevée (HDR) est le critère le plus récent en matière de photos et de vidéos. Le HDR est initialement devenu populaire parmi les photographes désireux de révéler de manière appropriée un maquillage avec 2 sujets ayant une différence de 13 diaphragmes dans la valeur d’exposition. Une telle variété vibratoire permettrait certainement une exposition directe correcte des scènes de la vie réelle, ce qui n’était auparavant pas possible avec la SDR.

Plus récemment, la HDR a été présentée aux films, aux clips vidéo, mais aussi aux jeux. Alors que le matériel SDR offrait des ciels exagérés, des noirs tantamount et des problèmes de banding tout au long des scènes à fort contraste, le HDR représente ces scènes de manière réaliste avec une chambre de couleurs, une profondeur de nuance et une luminosité plus importantes.

Une zone de couleur plus large, une profondeur de teinte plus grande et une luminance plus élevée rendent la HDR bien meilleure que la SDR… mais de combien ?

Comparaison entre la HDR et la SDR

Si vous êtes resté un jour sur le marché pour un écran, vous avez peut-être vu certaines spécifications telles que sRGB, nits ainsi que cd/m2, ainsi que des couleurs 10 bits. Ces exigences concernent l’espace des nuances, la luminosité et la profondeur des couleurs. Toutes ces exigences sont ce qui rend les sujets vivants, bien mélangés, et également soumis de manière appropriée à l’intérieur d’une image.

Pour bien mieux comprendre la différence entre HDR et SDR, comparons les deux à travers leur gamme de nuances, leur luminosité, ainsi que leur profondeur de couleur. Commençons par la gamme de nuances.

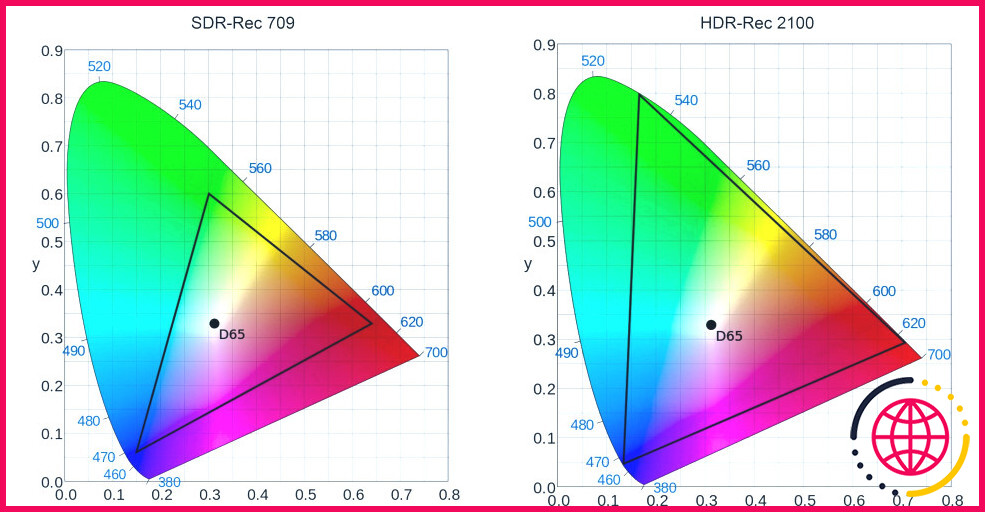

Gamme de couleurs

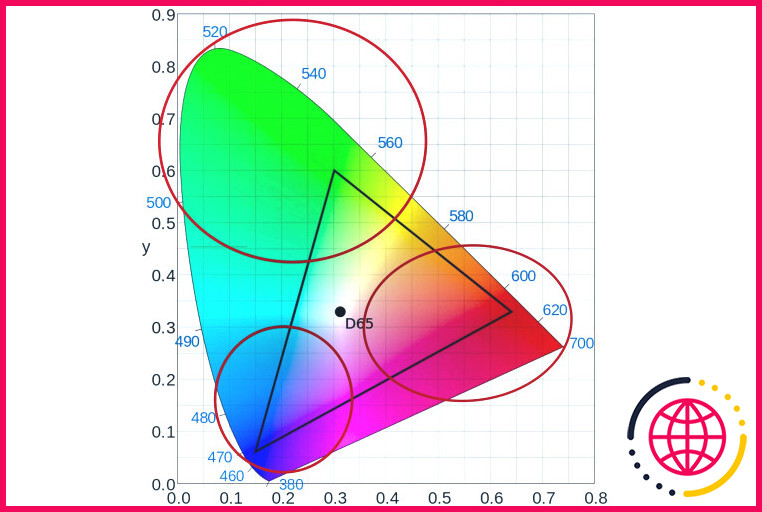

Un gamut de couleurs est un spectre académique de nuances qui peuvent être représentées numériquement. Pour représenter toutes les couleurs réalisables que les yeux peuvent voir, l’industrie utilise ce qui est connu comme le diagramme de chromaticité CIE 1931. Ce diagramme est le point commun avec lequel les différentes salles de couleurs sont comparées. La SDR utilise une zone de couleur appelée Rec 709 et la HDR la Rec 2100. Le triangle représente la quantité de chambre qu’ils utilisent à travers l’image listée ci-dessous :

Comme vous pouvez le constater, la zone de couleur utilisée par la Rec 2100 de la HDR est sensiblement plus grande que celle de la Rec 709 de la SDR.

Avec la grande chambre de couleurs de la HDR, les réalisateurs de films ainsi que les divers concepteurs de contenu web disposeront d’une gamme de verts, de rouges et aussi de jaunes nettement plus importante pour représenter leur travail de manière précise et attrayante. Cela signifie que les téléspectateurs appréciant le HDR verront des couleurs plus vives, en particulier dans les amis de l’environnement, les jaunes, les rouges, et tout ce qui se trouve entre les deux.

Quant à la SDR, étant donné que la zone de couleur a effectivement en proportion des quantités de primaires, les coloristes peuvent encore représenter leur travail merveilleusement, bien qu’avec des limitations considérables.

Luminosité

Vous avez vu la gamme de couleurs représentée en 2D comme celle utilisée précédemment. Néanmoins, l’ensemble de l’espace des couleurs de la CIE 1931 est en fait une disposition en 3D. La troisième mesure de la disposition représente l’illumination perçue de la couleur. La luminosité, ainsi que la saturation, sont ce qui personnalise la qualité supérieure de la couleur que les humains peuvent voir.

Un écran d’affichage qui peut produire de plus grandes quantités de luminance est beaucoup plus efficace pour personnaliser toutes les tonalités que le nuancier 2D représente et peut donc montrer plus de couleurs visibles par les yeux humains. La luminance est déterminée en nits ou en candela/m2.

SDR peut sortir 100nits ou 100cd/m2. En revanche, le HDR10 (l’exigence HDR la plus typique) peut sortir jusqu’à 1 000 nits. Cela indique que voir en HDR10 peut permettre aux visiteurs de voir encore plus de variétés de nuances primaires ainsi que de nuances supplémentaires.

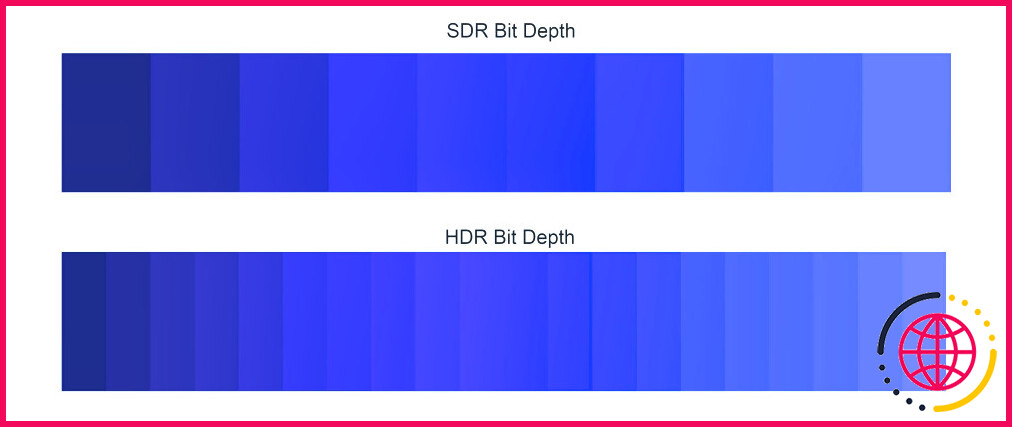

Profondeur des couleurs

Bien que les yeux humains voient tout en analogique, les écrans numériques doivent simuler ces ondes analogiques de lumière en bits numériques pour que les processeurs puissent les recréer. Ces petits bits d’informations numériques sont connus sous le nom de profondeur de couleur ou petits bits de nuances.

L’œil humain utilise la supposition pour voir les différentes nuances. Les écrans numériques utilisent la profondeur des couleurs ou la profondeur des bits pour conseiller un pixel sur la couleur à afficher. Plus le nombre de petits bits d’un pixel est élevé, plus il peut afficher de couleurs.

SDR peut présenter 8 bits de couleur, indiquant qu’un pixel peut montrer une couleur primaire dans 256 gammes. Étant donné qu’il y a trois primaires, un panneau de 8 bits peut afficher un optimum de 16 777 216 tons d’ombre.

Pour mettre cela en perspective, l’œil humain ne peut distinguer qu’environ 10 millions de nuances. Cela implique que la DTS est extrêmement avec la capacité d’afficher les nuances que nos yeux humains peuvent voir, ce qui explique pourquoi la nuance 8 bits est toujours l’exigence pour les médias esthétiques aujourd’hui.

En comparaison, HDR10 peut faire une profondeur d’ombre de 10 bits, permettant un maximum de 1,07 milliard de tons d’ombre !

Impressionnant, mais comme l’œil humain ne peut différencier qu’environ 10 millions de couleurs, une profondeur de couleur de 10 bits n’est-elle pas exagérée ? Pouvez-vous même voir la différence ?

Oui, vous le pourriez certainement ! Mais comment ?

Les gens peuvent voir beaucoup plus de nuances avec une profondeur de 10 bits, car l’œil humain ne voit pas les nuances de couleurs de la même façon.

Si vous considérez l’échelle de chromaticité CIE 1931 (illustrée ci-dessus), vous pouvez constater que l’œil humain peut voir beaucoup plus d’éco-amis et de rouges que de bleus. Bien qu’une profondeur de teinte de 8 bits puisse soigneusement tirer le meilleur parti de tous les bleus que vos yeux peuvent percevoir, elle peut s’abstenir de faire exactement la même chose avec les rouges, ainsi que spécifiquement avec les verts. Ainsi, même si vous verrez à peu près la même variété de bleus en 8 et 10 bits, d’autres primaires comme les rouges et les verts se révèleront davantage sur un système utilisant une profondeur de couleur de 10 bits.

Avantages et inconvénients de la HDR et de la SDR

HDR et SDR sont 2 critères utilisés dans les médias numériques visuels. L’utilisation d’une exigence d’une autre aura certainement ses routes ainsi que ses faiblesses. Vous trouverez ci-dessous un tableau pour vous montrer comment l’un se compare à l’autre :

En ce qui concerne l’ombrage et l’affichage, la HDR est bien meilleure que la SDR à tous les égards. Elle donne des rénovations significatives dans la zone d’ombre, la luminosité, ainsi que la profondeur des couleurs. Donc, si vous avez la possibilité de regarder des films, des photos ou des jeux en HDR, vous devriez constamment le faire… mais le pouvez-vous ?

Le problème avec le HDR est que la plupart des médias appétissants ne sont pas adaptés au HDR. Typiquement, regarder un média HDR sur un écran SDR rendra certainement votre expérience de visionnement pire que de le voir sur un panneau SDR de routine.

Un autre problème est que la plupart des outils HDR font usage de HDR10, qui est vaguement standard, tandis que son marketing est largement uniforme. Par exemple, vous trouverez la conception du logo HDR10 ajouté un panneau subpar qui ne peut pas effectuer aussi bien que le panneau de 1 000 nits a reçu des publicités HDR10.

Bien que SDR fournit les exigences de visualisation habituelles et ne peut pas rivaliser avec HDR quand il fonctionne, sa facilité d’utilisation, la compatibilité, et aussi les dépenses réduites est pourquoi beaucoup d’individus aiment encore l’utiliser.

Vous avez besoin à la fois de la HDR et de la SDR

Maintenant que vous reconnaissez la différence entre les exigences de la SDR et celles de la HDR, il est évident que la HDR est la grande gagnante lorsqu’il s’agit de voir du matériel amusant. Néanmoins, cela n’indique pas que vous devez cesser d’utiliser la DTS. Le fait est que la SDR reste la meilleure norme à utiliser chaque fois que vous ne voyez ou ne jouez pas de matériel spécifique à la HDR.

Si vous vous procurez un tout nouvel écran, il serait judicieux d’acheter un panneau compatible HDR plus coûteux, car il vous permet de visualiser à la fois du matériel HDR et SDR. Étant donné que le contenu web SDR a un aspect négatif en HDR10, vous pouvez toujours désactiver le HDR lorsque vous appréciez, jouez ou regardez du contenu web et des applications SDR.

Avec un peu de chance, cela vous donne une idée de l’impact que la HDR apporte sur la table. Bien que la SDR soit encore le moyen par lequel vous prenez plaisir à de nombreux contenus web, ce n’est qu’une question de temps jusqu’à ce que la HDR obtienne un meilleur support. Après cela, il sera probablement le futur conventionnel que tout le monde utilise.

Est-ce que le 4K SDR ou le HDR ?

Plage dynamique standard 4K (SDR) : utilisée pour les téléviseurs 4K qui ne prennent pas en charge HDR10 ou Dolby Vision. 4K High Dynamic Range (HDR) : Utilisé pour les téléviseurs 4K qui prennent en charge le HDR pour afficher la vidéo avec une gamme plus large de couleurs et de luminance.

Quel est le meilleur 4K SDR ou 1080p HDR ?

Le HDR offre un contraste plus élevé (ou une plage de couleurs et de luminosité plus large) que la plage dynamique standard (SDR) et a plus d’impact visuel que le 4K. Cela dit, 4K offre une image plus nette et mieux définie.

Que signifie SDR à la télévision ?

La vidéo à plage dynamique standard (SDR) est une technologie vidéo qui représente l’intensité lumineuse en fonction des caractéristiques et des limites de luminosité, de contraste et de couleur d’un écran à tube cathodique (CRT).